Мы в «Латере» занимаемся созданием биллинга для операторов связи и рассказываем на Хабре о разработке своего продукта, а также публикуем интересные технические переводные материалы. И сегодня мы представляем вашему вниманию адаптированный перевод одной из глав книги «Архитектура open-source-приложений», в которой описываются предпосылки появления, архитектура и организация работы популярного веб-сервера nginx.Читать полностью »

Рубрика «Apache» - 11

Архитектура open source-приложений: Как работает nginx

2015-12-16 в 11:28, admin, рубрики: Apache, nginx, open source, архитектура, Блог компании Латера Софтвер, Веб-разработка, веб-сервер, веб-серверы, системное администрированиеSSO на FreeIPA+Apache+Flask-Login+JWT

2015-04-12 в 19:35, admin, рубрики: Apache, flask, Flask-Login, freeipa, jwt, kerberos, python, информационная безопасность, разработкаВсем привет

В статье описывается разработка и развёртывание системы SSO-аутентификации, использующей Kerberos и JWT. Модуль аутентификации разработан с применением Flask, Flask-Login и PyJWT. Развёртывание выполнено с использованием веб-сервера Apache, сервера идентификации FreeIPA и модуля mod_lookup_identity на CentOS 6/7. В статье много текста, средне кода и мало картинок. В общем, будет интересно :)

Видеообзор ноутбука MSI GE62 2QE Apache

2015-04-08 в 9:45, admin, рубрики: Apache, GE62, MSI, Блог компании НОТИК, ноутбук, Ноутбуки, обзорУстановка FAMP на pfsense

2015-04-03 в 10:54, admin, рубрики: 1С-Битрикс, Apache, cms, freebsd, lamp, mysql, pfsense, php, webhosting, webserverВ стандартных пакетах pfsense нет ни MySQL, ни полноценного Apache. PHP присутствует в системе по умолчанию, являясь основным языком сценариев, но отсутствуют нужные модули mysql.so и присутствуют свои pfsense.so, ssh2.so и т.д.

В отличие от FreeBSD, убраны многие стартовые скрипты и файлы конфигурации (rc.conf, rc.local), вместо них используются свои механизмы, написанные на PHP.

Читать полностью »

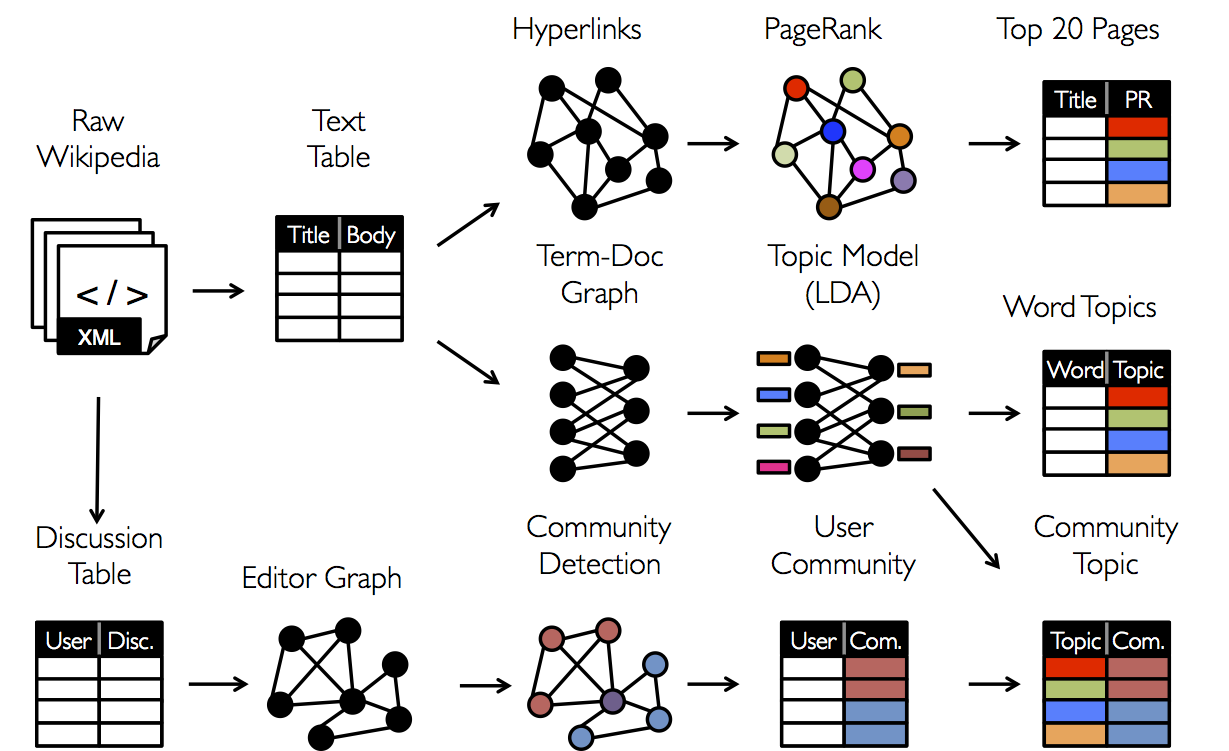

Big Data на практике: ожидание VS реальность

2015-03-30 в 8:57, admin, рубрики: Apache, big data, data mining, machine learning, анализ данных, математика, машинное обучение, практике, Программирование  Привет, хабр!

Привет, хабр!

После последней публикации «Ваш персональный курс по Big Data» мне пришло несколько сотен писем с вопросами, читая которые, я с удивлением обнаружил, что люди очень сильно погружаются в теорию, уделяя мало времени решению практических задач, в которых навыки необходимы совершенно другие. Cегодня я расскажу, какие сложности появляются на практике и с чем приходится работать при решении реальных задач.

Читать полностью »

Проект Groovy намерен присоединиться к Apache Software Foundation

2015-03-16 в 7:31, admin, рубрики: Apache, apache software foundation, asf, groovy, java, jvmЭто перевод вот этой публикации из блога Гийома Лафорджа, официального менеджера проекта Groovy.

Команда Groovy рада объявить о своём намерении присоединиться к Apache Software Foundation (ASF).

Вслед за недавним объявлением от Pivotal об окончании финансирования постоянных разработчиков проекта Groovy, команда решила, что было бы целесообразно продемонстрировать Groovy-сообществу, что в долгосрочной перспективе проект не исчезнет. Groovy будет развиваться вне зависимости от наличия финансирования частными организациями и спонсорами, а так же вне зависимости от каких-либо изменений в команде разработчиков.

Читать полностью »

Обучение на больших данных: Spark MLlib

2015-02-26 в 13:53, admin, рубрики: Apache, big data, data mining, Hadoop, python, spark, анализ данных, Большие данные, машинное обучение, разработкаПривет!

В прошлый раз мы познакомились с инструментом Apache Spark, который в последнее время становится чуть ли не самым популярным средством для обработки больших данных и в частности, Large Scale Machine Learning. Сегодня мы рассмотрим подробнее библиотеку MlLib, а именно — покажем, как решать задачи машинного обучения — классификации, регресии, кластеризации, а также коллаборативной фильтрации. Кроме этого покажем, как можно исследовать признаки с целью отбора и выделения новых (т.н. Feature Engineering, о котором мы говорили ранее, причем не один раз).

Читать полностью »

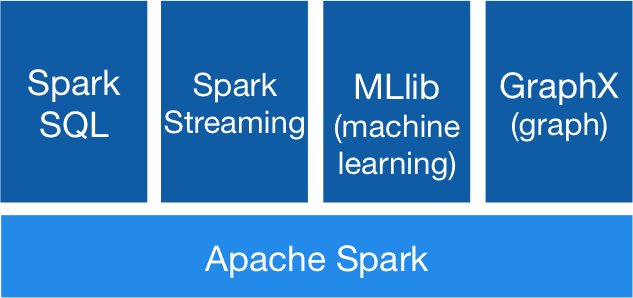

Apache Spark: что там под капотом?

2015-02-26 в 0:46, admin, рубрики: Apache, big data, big data analytics, data mining, Hadoop, mpp, spark, sparsql, параллельные вычисленияВступление

В последнее время проект Apache Spark привлекает к себе огромное внимание, про него написано большое количество маленьких практических статей, он стал частью Hadoop 2.0. Плюс он быстро оброс дополнительными фреймворками, такими, как Spark Streaming, SparkML, Spark SQL, GraphX, а кроме этих «официальных» фреймворков появилось море проектов — различные коннекторы, алгоритмы, библиотеки и так далее. Достаточно быстро и уверенно разобраться в этом зоопарке при отсутсвие серьезной документации, особенно учитывая факт того, что Spark содержит всякие базовые кусочки других проектов Беркли (например BlinkDB) — дело непростое. Поэтому решил написать эту статью, чтобы немножко облегчить жизнь занятым людям.

Небольшая предыстория:

Spark — проект лаборатории UC Berkeley, который зародился примерно в 2009г. Основатели Спарка — известные ученые из области баз данных, и по философии своей Spark в каком-то роде ответ на MapReduce. Сейчас Spark находится под «крышей» Apache, но идеологи и основные разработчики — те же люди.

Spoiler: Spark в 2-х словах

Spark можно описать одной фразой так — это внутренности движка массивно-параллельной СУБД. То есть Spark не продвигает свое хранилище, а живет сверх других (HDFS — распределенная файловая система Hadoop File System, HBase, JDBC, Cassandra,… ). Правда стоит сразу отметить проект IndexedRDD — key/value хранилище для Spark, которое наверное скоро будет интегрировано в проект.Также Spark не заботится о транзакциях, но в остальном это именно движок MPP DBMS.

RDD — основная концепция Spark

Ключ к пониманию Spark — это RDD: Resilient Distributed Dataset. По сути это надежная распределенная таблица (на самом деле RDD содержит произвольную коллекцию, но удобнее всего работать с кортежами, как в реляционной таблице). RDD может быть полностью виртуальной и просто знать, как она породилась, чтобы, например, в случае сбоя узла, восстановиться. А может быть и материализована — распределенно, в памяти или на диске (или в памяти с вытеснением на диск). Также, внутри, RDD разбита на партиции — это минимальный объем RDD, который будет обработан каждым рабочим узлом.

Как создать поддомен в VestaCP

2015-02-25 в 8:25, admin, рубрики: Apache, CentOS, control panel, httpd, linux, nginx, vesta, системное администрирование, хостингПосещая форум поддержки панели VestaCP, заметил, что часто пользователи спрашивают, как создать поддомен в VestaCP.

На самом деле, это очень просто. Для начала нужно зайти в саму панель:

Читать полностью »