Удивительно, но факт: несколько изменений в изображении может полностью изменить вывод нейросети, что ломает заложенную разработчиком логику. В данной статье мы не просто подсветим факт существования One Pixel атаки, но и комплексно разберём архитектурные факторы, которые влияют на устойчивость CV-систем к данному семейству атак.

Рубрика «alexnet»

Когда несколько пикселей решают всё: One Pixel атака и способы защиты от неё

2025-07-31 в 15:15, admin, рубрики: alexnet, computer vision, efficientnet, inceptionV3, one pixel attack, resnet, Visual transformerВедущий разработчик ChatGPT и его новый проект — Безопасный Сверхинтеллект

2025-04-07 в 9:01, admin, рубрики: 10x engineer, alexnet, AlphaGo, chatgpt, CUDA, DNNResearch, few-shot learning, Google Brain, gpgpu, gpt, gpu, Ilya Sutskever, ImageNet, lenet, Nvidia GTX 580, OpenAI, ruvds_статьи, Safe Superintelligence, seq2seq, TensorFlow, word2vec, Алекс Крижевски, Джеффри Хинтон, илья суцкевер, Компьютерное зрение, машина Больцмана, неокогнитрон, сверхинтеллект, Томаш Миколов

Многие знают об Илье Суцкевере только то, что он выдающийся учёный и программист, родился в СССР, соосновал OpenAI и входит в число тех, кто в 2023 году изгнал из компании менеджера Сэма Альтмана. А когда того вернули, Суцкевер уволился по собственному желанию в новый стартап Safe Superintelligence («Безопасный Сверхинтеллект»).

Илья Суцкевер действительно организовал OpenAI вместе с Маском, Брокманом, Альтманом и другими единомышленниками, причём был главным техническим гением в компании. Ведущий учёный OpenAI сыграл ключевую роль в разработке ChatGPT и других продуктов. Сейчас Илье всего 38 лет — совсем немного для звезды мировой величины.Читать полностью »

7 лет хайпа нейросетей в графиках и вдохновляющие перспективы Deep Learning 2020-х

2019-12-25 в 7:01, admin, рубрики: alexnet, AutoML, Batch Normalization, big data, cnn, computer science, data science, deep learning, Deepfake, deeplab, DenseNet, dropout, GAN, hardware acceleration, pytorch, resnet, TensorFlow, vgg, искусственный интеллект, машинное обучение, Научно-популярное, нейросети, скорость прогресса, Статистика в IT

Новый год все ближе, скоро закончатся 2010-е годы, подарившие миру нашумевший ренессанс нейросетей. Мне не давала покоя и лишала сна простая мысль: «Как можно ретроспективно прикинуть скорость развития нейросетей?» Ибо «Тот, кто знает прошлое — тот знает и будущее». Как быстро «взлетали» разные алгоритмы? Как вообще можно оценить скорость прогресса в этой области и прикинуть скорость прогресса в следующем десятилетии?

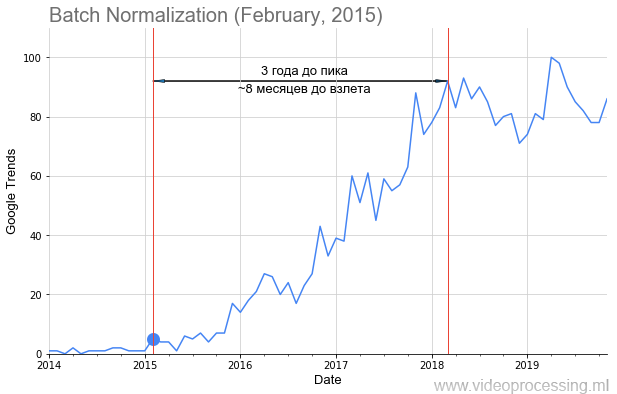

Понятно, что можно примерно посчитать количество статей по разным областям. Метод не идеальный, нужно учитывать подобласти, но в целом можно пробовать. Дарю идею, по Google Scholar (BatchNorm) это вполне реально! Можно считать новые датасеты, можно новые курсы. Ваш же покорный слуга, перебрав несколько вариантов, остановился на Google Trends (BatchNorm).

Мы с коллегами взяли запросы основных технологий ML/DL, например, Batch Normalization, как на картинке выше, точкой добавили дату публикации статьи и получили вполне себе график взлета популярности темы. Но не у всех тем путь усыпан розами взлет такой явный и красивый, как у батчнорма. Некоторые термины, например регуляризацию или skip connections, вообще не получилось построить из-за зашумленности данных. Но в целом тренды собрать удалось.

Кому интересно, что получилось — добро пожаловать под кат!

Читать полностью »

Эффективные методы сжатия данных при тренировке нейросетей. Лекция в Яндексе

2018-03-11 в 12:37, admin, рубрики: alexnet, CNTK, cpu, DNN, fragmentation, gist, gpu, gzip, lcp, LSTM, memory management, mxnet, pool, reinforcement learning, relu, resnet, TensorFlow, Блог компании Яндекс, глубокие сети, машинное обучение, сжатие данныхНе так давно в Яндекс приезжал Геннадий Пехименко — профессор Университета Торонто и PhD Университета Карнеги-Меллон. Он прочитал лекцию об алгоритмах кодирования, которые позволяют обходить проблему ограничения памяти GPU при обучении глубоких нейронных сетей.

— Я вхожу в несколько групп Университета Торонто. Одна из них — Computer Systems and Networking Group. Есть еще моя собственная группа — EcoSystem Group. Как видно из названий групп, я не специалист непосредственно в машинном обучении. Но нейронные сети сейчас достаточно популярны, и людям, которые занимаются компьютерной архитектурой и сетями, компьютерными системами, приходится сталкиваться с этими приложениями на постоянной основе. Поэтому последние полтора-два года этой темой я тоже плотно занимаюсь.

Читать полностью »

Как HBO делала приложение Not Hotdog для сериала «Кремниевая долина»

2017-06-27 в 10:53, admin, рубрики: alexnet, appstore, Cyclical Learning Rates, DX, Enet, Google Cloud Vision, ImageNet, inception, keras, react native, SqueezeNet, TensorFlow, UX, Xception, глубинное обучение, зловещая долина, Компьютерное зрение, машинное обучение, обработка изображений, переобучение, разработка мобильных приложений, Разработка под android, разработка под iOS, метки: Google Cloud Vision

Сериал HBO «Кремниевая долина» выпустил настоящее приложение ИИ, которое распознаёт хотдоги и не-хотдоги, как приложение в четвёртом эпизоде четвёртогого сезона (приложение сейчас доступно для Android, а также для iOS!)

Чтобы добиться этого, мы разработали специальную нейронную архитектуру, которая работает непосредственно на вашем телефоне, и обучили её с помощью TensorFlow, Keras и Nvidia GPU.

Читать полностью »

Обзор топологий глубоких сверточных нейронных сетей

2016-10-12 в 15:59, admin, рубрики: alexnet, artificial intelligence, convolutional neural network, ImageNet, inception, lenet, math, neural networks, nin, resnet, skynet, vgg, Алгоритмы, Блог компании Mail.Ru Group, математика, машинное обучение, обработка изображений Это будет длиннопост. Я давно хотел написать этот обзор, но sim0nsays меня опередил, и я решил выждать момент, например как появятся результаты ImageNet’а. Вот момент настал, но имаджнет не преподнес никаких сюрпризов, кроме того, что на первом месте по классификации находятся китайские эфэсбэшники. Их модель в лучших традициях кэгла является ансамблем нескольких моделей (Inception, ResNet, Inception ResNet) и обгоняет победителей прошлого всего на полпроцента (кстати, публикации еще нет, и есть мизерный шанс, что там реально что-то новое). Кстати, как видите из результатов имаджнета, что-то пошло не так с добавлением слоев, о чем свидетельствует рост в ширину архитектуры итоговой модели. Может, из нейросетей уже выжали все что можно? Или NVidia слишком задрала цены на GPU и тем самым тормозит развитие ИИ? Зима близко? В общем, на эти вопросы я тут не отвечу. Зато под катом вас ждет много картинок, слоев и танцев с бубном. Подразумевается, что вы уже знакомы с алгоритмом обратного распространения ошибки и понимаете, как работают основные строительные блоки сверточных нейронных сетей: свертки и пулинг.

Это будет длиннопост. Я давно хотел написать этот обзор, но sim0nsays меня опередил, и я решил выждать момент, например как появятся результаты ImageNet’а. Вот момент настал, но имаджнет не преподнес никаких сюрпризов, кроме того, что на первом месте по классификации находятся китайские эфэсбэшники. Их модель в лучших традициях кэгла является ансамблем нескольких моделей (Inception, ResNet, Inception ResNet) и обгоняет победителей прошлого всего на полпроцента (кстати, публикации еще нет, и есть мизерный шанс, что там реально что-то новое). Кстати, как видите из результатов имаджнета, что-то пошло не так с добавлением слоев, о чем свидетельствует рост в ширину архитектуры итоговой модели. Может, из нейросетей уже выжали все что можно? Или NVidia слишком задрала цены на GPU и тем самым тормозит развитие ИИ? Зима близко? В общем, на эти вопросы я тут не отвечу. Зато под катом вас ждет много картинок, слоев и танцев с бубном. Подразумевается, что вы уже знакомы с алгоритмом обратного распространения ошибки и понимаете, как работают основные строительные блоки сверточных нейронных сетей: свертки и пулинг.