Цели:

Увеличить точность нахождения области губ разрабатываемой системы для пользователей с различными типами лица, цвета кожи, особенностей строения губ, характеристикам окружающей среды, освещения и так далее.

Задачи:

Провести фотографирования вариаций губ пользователей в различных положениях для увеличения точности системы ручным способом. Реализовать библиотеку базы данных системы по различным типам губ в движении на основе свободной системы управления базами данных (СУБД).

Введение

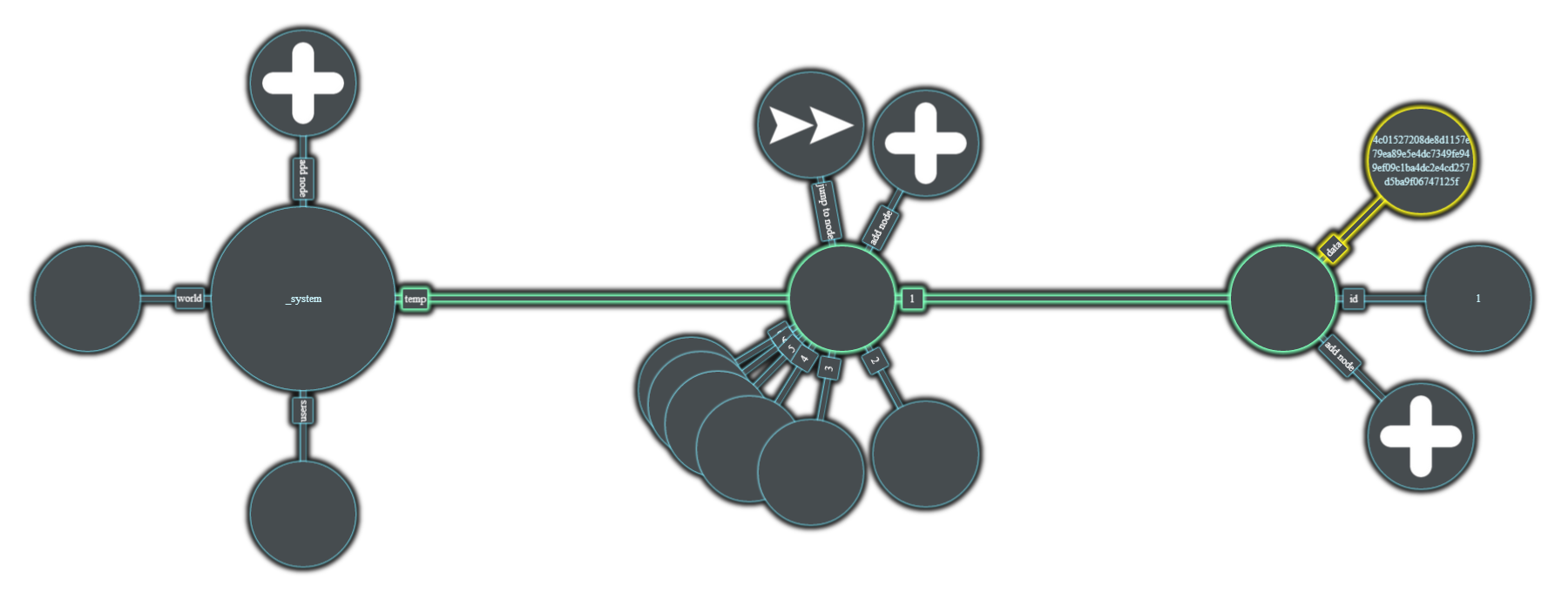

В предыдущих отчетах мною были проанализированы различного рода цветовые пространства, оптимальные для выделения объектов на заданном классе изображениях. Были исследованы различные алгоритмы распознавания человеческого лица и его характеристик. Также рассмотрены разного рода математические модели, которые могут использоваться для обработки визуальных данных в режиме реального времени. На основе проведенного исследования был реализован свой собственный алгоритм нахождения области губ. Однако точность активной контурной модели интересуемого объекта в представленном решении не всегда соответствует действительности. Так как перед нами стоит задача реализовать пользовательский продукт, то для увеличения точности модульного визуального решения в данном научном исследовании перед нами стоит задача собрать библиотеку данных по различным типам губ пользователей.

1. Фотографирование вариаций губ с разными типами лиц.

Так как представленной системе по разным причинам не всегда удавалось правильно провести локализацию области губ самостоятельно, то для того чтобы технология стала более эффективной было решено исследовать разные типы губ пользователей вручную, чтобы занести исходные данные на следующем этапе в базу данных системы.

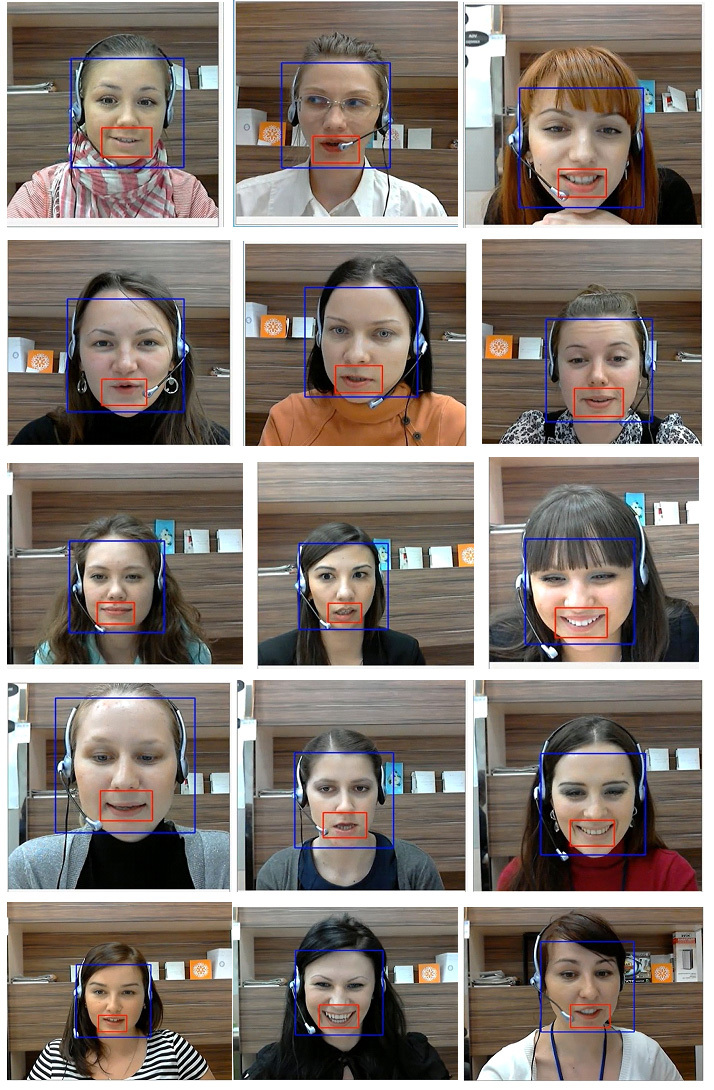

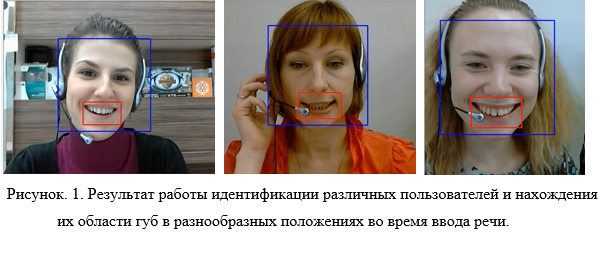

Для осуществления данной задачи тестирования было проанализировано движение губ 18 пользователей. Исходные данные были сфотографированы вручную. Рисунок 1 демонстрирует лица пользователей с местом локализации области губ во время произношения речи.