Бороться и искать. Найти и перепрятать

Достаточно популярная поговорка во времена Союза.

Вот и сейчас, те у кого сервер 1С в локальной сети мечтают вынести его в облако, а те у кого в облаке прикупить свой в локальную сеть.

7 декабря 2018 г. AlexandrSurkov пригласил желающих: Яндекс открывает Облако. Архитектура новой платформы

Как у обычного пользователя у меня не нашлось чем занять этот ресурс, но как 1С-ник я подумал: А пуркуа бы и не па ? И попробовал положить в облако от Яндекса 1С Предприятие.

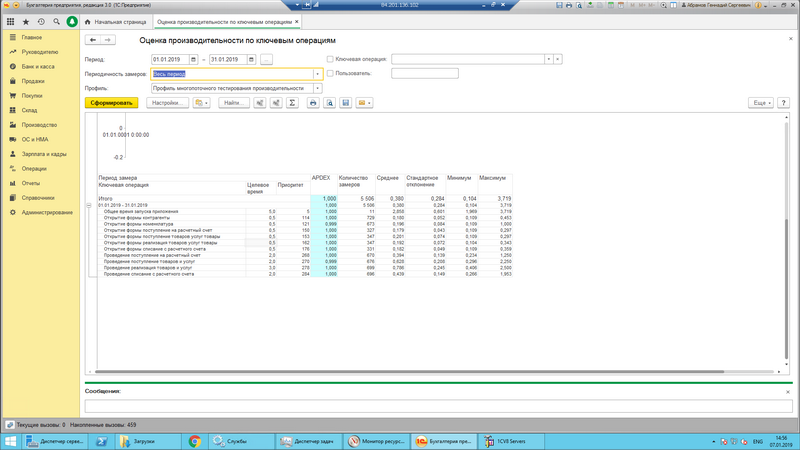

Тестирование Яндекс.Облако Compute Cloud для 1С Предприятие оставило у меня приятное впечатление.

Возможно кто-то повторит его и внесет больше ясности в настройки виртуальных серверов, использованию API и так далее. Интересующихся прошу продолжить чтение…