Студент в Big Data получает 70 тысяч рублей в месяц, а специалист с опытом 3-4 года — 250 тысяч рублей в месяц. Это те, например, кто умеет персонализировать предложения розницы, искать в соцсети человека по анкетным данным заявки на кредит или по списку посещённых сайтов вычислять новую симку старого абонента.

Мы решили сделать профессиональный курс по Big Data без «воды», маркетинга и всяких эджайлов, только хардкор. Позвали практиков из 7 крупных компаний (включая Сбербанк и Oracle) и устроили, фактически, хакатон длиной во весь курс. Недавно у нас прошел день открытых дверей по программе, где мы напрямую спросили практиков, что же есть Big Data в России, и как компании на деле используют большие данные. Ниже ответы.

Сбербанк

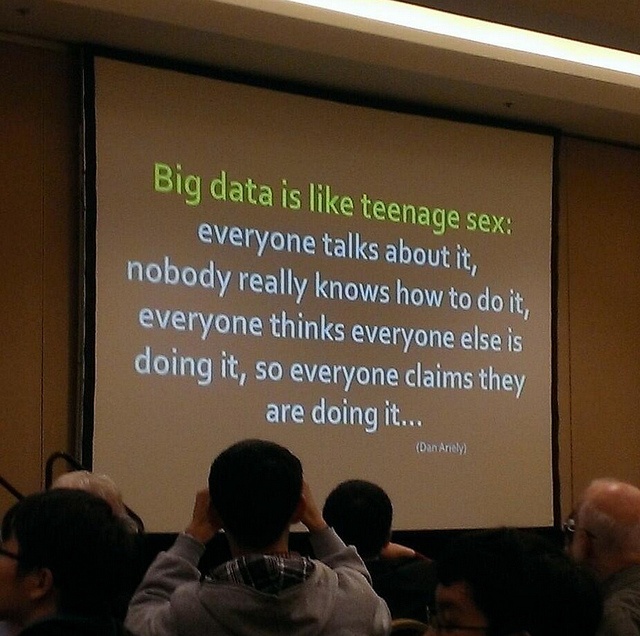

Екатерина Фроловичева, начальник отдела технологических исследований Сбербанк России, говорит, что Big Data — это хороший красивый маркетинг, термин, который сформировался из целого ряда дисциплин, которые существовали не вчера, не позавчера, и не два-три года назад. Машинное обучение, data mining — всё это в сочетании просто используется для решения задач.

Где тонкая грань между классической аналитикой и большими данными? Если вы можете уместить свои данные в обычной таблице с измеряемым количеством строк и создавать к ней агрегированные запросы — это классическая аналитика. Но если вы берете разнородные источники информации и исследуете их по разным параметрам, причем в реальном времени — это и есть Big Data.

По клиентам очевидные вещи — массовая персонализация и все то, что может помочь увеличить количество вторичных продаж. Активных держателей карт Сбербанка — 50 млн. Это не те, кто просто имеет карты, а те, кто тратит. Как их попытаться идентифицировать по их вектору интересов, по какому набору параметров, признаков, по какому ID их распознать, что они у нас записаны где-то в какой-то system of record — это первый срез, который надо преодолеть. А как сделать, чтобы в режиме реального времени пользователю пришло предложение, на которое он откликнется, — это ровно те задачи, на которые стоит ориентироваться. Те кейсы, которые описывают работу compliance и проблемных активов, я бы не хотела раскрывать, т.к. это вопросы не публичного знания.

Рынок труда

Павел Лебедев, руководитель направления исследований Superjob, сразу начал с денег и статистики. На момент выступления на дне открытых дверей по Big Data, в их статистике было примерно 200 вакансий прямо по теме и 80 вакансий о Data Science/Data mining. Шесть крупных российских компаний ищут специалистов постоянно, остальные — эпизодически. Больше всего Big Data-профессионалы нужны в телекомы, банки и крупный ритейл. Более того, чтобы попасть на работу в эти места, достаточно просто пройти усиленный специализированный курс на 1-2 месяца при наличии общего IT-бекграунда (немного математики, немного SQL).

Как правило, нужны бизнес-аналитики и инженеры по машинному обучению. Иногда ищут архитектора баз данных. Вообще, каждый работодатель понимает Big Data по-своему, и пока общих критериев как к C++ разработчикам, например, нет.

Что входит в работу такого человека? Как правило, сначала он должен отстроить процесс сбора данных, потом отстроить процесс его анализа. Аналитика, тестирование гипотез и т.п. Затем — внедрение полученных решений в бизнес-процессы непосредственно на предприятии.

Первый диапазон зарплаты — 70-80 тысяч рублей в месяц. Это начальный уровень, без опыта работы и глубокого знания языков программирования. Как правило, это выпускники ВУЗов. Предполагается, что в ВУЗе дали базовые знания SQL-запросов и, опять же, научили удалять выбросы при построении скользящего среднего.

Следующий диапазон до 100-120 тысяч рублей в месяц подразумевает уже больший набор практических знаний, работу с различными статистическими инструментами. Чаще всего SPSS, SAS Data Miner, Tableau и т.д. Нужно уметь визуализировать данные, чтобы доказывать другим людям, почему важно что-то конкретное делать. Проще говоря, надо будет встать на собрании инвесторов и объяснить, что вы там получили, но не на птичьем языке.

Третий диапазон — до примерно 180 тысяч рублей в месяц — появляются требования к программированию. Чаще всего упоминаются скриптовые языки Python и т.д., и уже опыт работы два года, опыт машинного обучения, использования Hadoop и т.д. А вот самые высокие зарплаты — до 250 тысяч рублей в месяц — это люди с очень высокой квалификацией. Определяется по опыту реализации чего-то конкретного на рынке, академическому внедрению и своим разработкам. Выше только эксклюзив, когда зарплата больше, но людей по стране с нужной квалификацией десятки или единицы.

Сбербанк уточняет: норма — за год от 1,5 до 3 миллионов рублей. И да, Сбербанк рассчитывает взять как минимум пару человек с ближайшего курса к себе на работу (но об этом ниже).

МТС

Эксперт — Сагинов Виталий, отвечает за направление Big Data в МТС.

«В начале 1990-х годов два математика пришли к выводу, что использование регрессионных методов анализа позволяет предсказать с достаточной долей вероятностью, как клиент банка будет платить по счетам — будет он оплачивать вовремя или будет допускать просрочку. Они ходили с этим по всему Манхэттену, предлагая City и всем остальным. Им говорили: «Нет, ребята. Вы что? У нас тут профессионалы, которые общаются с клиентом, которые по цвету зрачка могут определить просрочку на 3-й, 9-й или 12-й месяц». В результате, они нашли маленький региональный банк в Вирджинии, который назывался Signet. Качество кредитного портфеля улучшилась в два раза относительно изначально значения — до того, как они начали экспериментировать. Последующие 10 лет розничный бизнес этого банка был выведен в отдельную компанию, которая сейчас называется Capital One, и эта компания, этот банк входит в десятку крупнейших розничных банков США с количеством клиентов, по-моему, около 20 млн., и порядка 17-18 млрд. долларов клиентских денег. Фактически, эта компания поставила данные и их обработку в основу своей бизнес-стратегии и бизнес-модели».

Виталий говорит, что данные — это актив. Но рынка для этого актива нет, как когда-то не было рынка для онлайн-бизнеса до 2000-х годов. То же самое в Европе и США — рынка сейчас просто нет, поэтому большая часть реальных инвестиций идёт в работу с данными внутри компании для оптимизации своих процессов. Обычно сначала опытным путём устанавливается, что именно приносит прибыль, потом под это строится аппаратная и программная архитектура. Только одна компания позволила себе пойти обратным путём — British Telecom — но там Big Data делал бывший IT-директор, который идеально точно представлял, что нужно.

Виталий считает, что Big Data через 15-20 лет породит новый Интернет, а мы сейчас у его истоков. Конкретно сейчас главная проблема развития направления — это отсутствие точных юридических процедур, масса согласований и спорных моментов.

Oracle

Светлана Архипкина, лидер направления продаж Big Data Technology, Oracle, говорит, что первая группа кейсов вокруг больших данных — это то, что связано с клиентами, персонифицированный подход вроде предложения на скидку на подгузники, ещё когда отец не знал, что его 15-летняя дочь беременна.

Вторая группа задач, связанная с большими данными — это оптимизация, то есть все, что связано с моделированием и использованием очень больших объемов данных.

Третья группа — это все задачи, связанные с мошенничеством. Тут в ход идут различные решения по видеораспознаванию образов, по анализу неструктурированной информации. Это очень большой стек задач, особенно для банков и телекомов.

И самые новые задачи — кроссиндустриальные. Там чаще всего встают вопросы работы с уровнем баз данных, не относящихся к традиционным реляционным.

Acronis

Иван Луковников, директор по разработке продуктов, Acronis, рассказал, что две основных проблемы — как хранить эти данные и что с ними делать. Где-то 5-6 лет назад мы запустили сервис облачного хранения бэкапов, благодаря которому пользователи могли делать резервные копии своих ноутбуков, рабочих станции, серверов, и хранить их в нашем дата-центре, в нашем облаке. Первыми дата-центрами были дата-центры в США, Бостоне, во Франции и Страсбурге. Если бы мы организовали свое хранение облачных бэкапов на нетапах или девайсах от EMC, то стоимость гигабайта хранения была бы очень высокой, и это мероприятие, скорее всего, было бы коммерчески невыгодным. И с появлением таких гигантов, как Google, Amazon нам было бы тяжело выдерживать конкуренцию, потому что благодаря их огромным мощностям стоимость гигабайта данных у них довольно дешева. Поэтому перед нами стала задача разработать эффективную систему хранения, которая бы позволила наиболее дешево хранить эти данные.

Речь шла о lazy data — данных, которые единожды пишутся, и потом периодически читаются, либо удаляются. То есть это не те данные, которым нужен постоянный random access, не те данные, которые требуют высоких IOPS. Мы разработали собственную технологию хранения больших данных. Еще один вопрос, который стал перед нами – это то, как хранимые нами данные каталогизировать, индексировать и позволять нашим пользователям осуществлять быстрый поиск. Задача, на самом деле, нетривиальная, учитывая то, что данные хранятся распределено, с некоторой избыточностью. Кстати, разработка у нас сосредоточена в России, но есть новый центр в Таллине.

Одной из самых интересных была задача дедупликации данных. Когда мы говорим о Big Data, о распределённых данных, здесь как раз встает вопрос о распределенности этих узлов, хранящих данные, и о том, чтобы сделать эту дедупликацию эффективной. Здесь стоит вопрос о том, как синхроинизровать данные правильно между узлами, поэтому это все большая область. В Big Data нет задачи просто анализировать данные, всегда задача анализа данных вызвана каким-то коммерческим интересом. В нашем случае — это интересы эффективного хранения данных, эффективного к ним доступа.

Похожие задачи по lazy data — это медиа-данные (аудио и видео). Но, кажется, лучшие специалисты в области Big Data, наверное, работают в ЦРУ, потому, что то количество данных, которые они собирают, — весь этот объем информации просто так собирать не имеет смысла, у них тоже стоит задача аналитики этих данных, эффективного хранения.

Луиза Изнаурова, директор по разработке новых медиа CondeNast Russia добавила, что Big Data для журналистики может достаточно сильно поменять сферу.

Курс

Собственно, как видите, рынок Big Data испытывает жёсткий дефицит квалифицированных специалистов. Поэтому именно эти эксперты и ещё несколько представителей крупных компаний сделали ставку на профессиональный курс по Big Data, который позволит частично решить этот вопрос.

Первый набор уже был. 18 апреля будет второй набор на этот трёхмесячный курс. В программе — 3 части. Это три конкретных кейса, каждый из которых занимает один месяц, и они бесконечно практичны. Кейс №1 — это создание DMP-системы за месяц. Кейс №2 — это анализ социального графа на примере «Вконтакте». Это тоже займет целый месяц, и в результате этого нужно будет написать в команде анализатор этого социального графа на больших данных. Кейс №3 — рекомендательные системы. Опять-таки, эта история очень понятна и востребована со стороны бизнеса, многие про это говорили — каким образом можно предугадать, что хочет человек.

На рынке интересна и востребована не теория, а практика, поэтому технический специалист, специалист по обработке, анализу данных должен понимать, какую бизнес-задачу он решает, и стек технологий, который с этим связан, очень сильно зависит от этой бизнес-задачи. Это означает работу с совершенно реальными данными. Не с данными, которые высосаны из Wikipedia, не с данными, которые академически известны уже 25 раз, а с данными из бизнеса, и наши партнеры по бизнесу с нами ими делятся.

Сроки жестоки. За месяц построить DMP-систему с нуля — это тяжело. Мы это понимаем, и это означает, что курс будет очень интенсивным и требующим большой концентрации. Его можно совмещать с работой, но если кроме работы у вас в жизни будет этот курс, то всего остального уже не будет.

— Константин Круглов, основатель D.C.A. Alliance

Устроено так — три раза в неделю: вторник, четверг с 7 до 10 вечера, в субботу с 4 до 7.

Каждую неделю надо будет коммитить что-то конкретное. Один пропуск — и вы не проходите курс. Если вам нужна теория — идите на Курсеру, здесь же будет только практика. Работа будет командной, и команды будут постоянно перемешиваться.

Ещё одна история — конкурс D.C.A., который позволит вам в течение первого месяца вернуть назад деньгами от 25% стоимости вашего обучения, если вы напишете хороший алгоритм. Ачивка подобного плана есть в каждом задании.

Вот ссылка на подробности и программу.

Ожидается, что треть выпускников — аналитики, которые умеют пользоваться разного рода инструментами для анализа больших данных, отлаживать модели, проверять гипотезы и собирать данные (например, для компаний продаж или чтобы выявлять паттерны фрода), остальные две трети выпускников будут разработчиками, которые умеют развернуть инструменты для работы с большими данными и своими руками могут создать работающие системы (то есть, на входе это должны быть люди уровня архитекторов и прикладных программистов продвинутого уровня).

Автор: sashaturilin