Гектор Левекwiki утверждает, что его компьютер тупой. И ваш тоже. Siri и голосовой поиск Google умеют понимать заготовленные предложения. Например «Какие фильмы будут показывать неподалёку в 7 часов?» Но что насчёт вопроса «Может ли аллигатор пробежать стометровку с барьерами?» Такой вопрос никто раньше не задавал. Но любой взрослый может найти ответ на него (Нет. Аллигаторы не могут участвовать в беге с барьерами). Но если вы попытаетесь ввести этот вопрос в Google, то получите тонны информации о спортивной команде по лёгкой атлетике Florida Gators. Другие поисковые системы, такие как Wolfram Alpha, тоже не способны найти ответ на поставленный вопрос. Watson, компьютерная система выигравшая викторину «Jeopardy!», вряд ли покажет себя лучше.

В устрашающей статье, недавно представленной на международной объединённой конференции по искусственному интеллектуwiki, Левек, учённый из Торонтского Университета, занимающийся этими вопросами, отчитал всех, кто причастен к разработкам ИИ. Он утверждал, что коллеги забыли про слово «интеллект» в термине «искусственный интеллект».

Левек начал с критики знаменитого «Теста Тьюринга», в котором человек посредством серии вопросов и ответов пытается отличить машину от живого собеседника. Считается, что если компьютер сможет пройти тест Тьюринга, то мы можем уверенно заключить, что машина обладает интеллектом. Но Левек утверждает, что тест Тьюринга практически бесполезен, так как он представляет из себя простую игру. Каждый год несколько ботов проходят это испытание вживую в состязаниях за премию Лёбнера. Но победителей нельзя назвать по настоящему интеллектуальными; они прибегают к разного рода трюкам и по сути занимаются обманом. Если человек спросит бота «Какой у тебя рост?» то система будет вынуждена фантазировать, чтобы пройти тест Тьюринга. На практике оказалось, что боты победители слишком часто хвастаются и пытаются ввести в заблуждение, чтобы их можно было назвать интеллектуальными. Одна программа прикидывалась параноиком; другие хорошо себя показали в использовании троллинга собеседника однострочными фразами. Очень символично, что программы прибегают к разного рода уловкам и жульничеству в попытках пройти тест Тьюринга. Истинное предназначение ИИ — построить интеллект, а не создать программу, заточенную на прохождения одного единственного теста.

Пытаясь направить поток в правильное русло, Левек предлагает исследователям в области ИИ другой тест, гораздо сложнее. Тест основанный на работе, которую он провёл с Леорой Моргенштерн (Leora Morgenstern) и Эрнестом Дэвисом (Ernest Davis). Вместе они разработали набор вопросов под названием Схемы Винограда, названные в честь Терри Виноградаwiki, первопроходца в области искусственного интеллекта в Стэнфордском Университете. В начале семидесятых Виноград задался вопрос построения машины, которая будет в состоянии ответить на следующий вопрос:

Городские управляющие отказались дать разрешение злобным демонстрантам, потому что они боялись насилия. Кто боится насилия?

а) Городские управляющие

б) Злобные демонстранты

Левек, Девис и Моргенштерн разработали набор подобных задач, которые кажутся простыми для разумного человека, но очень сложны для машин, которые умеют только гуглить. Некоторые из них трудно решить с помощью Google, потому что в вопросе фигурируют вымышленные люди, на которых по определению мало ссылок в поисковике:

Джоанна непременно отблагодарила Сюзанну за ту помощь, которую она ей оказала. Кто оказал помощь?

а) Джоанна

б) Сюзанна

(Чтобы усложнить задание можно заменить «оказала» на «получила»)

Можно по пальцам пересчитать веб-страницы, на которых человек по имени Джоанна или Сюзанна оказывают кому-то помощь. Поэтому ответ на такой вопрос требует очень глубокого понимания тонкостей человеческого языка и природы социального взаимодействия.

Другие вопросы сложно нагуглить по той же причине, почему вопрос про аллигатора трудно поддаётся поиску: аллигаторы реальны, но конкретный факт фигурирующий в вопросе редко обсуждается людьми. Например:

Большой шар проделал дыру в столе, потому что он был сделан из пенопласта. Что было сделано из пенопласта? (В альтернативной формулировке пенопласт заменяется на железо)

а) Большой шар

б) Стол

Сэм попытался нарисовать картинку пастуха с бараном, но в итоге он получился похожим на гольфиста. Кто получился похожим на гольфиста?

а) Пастух

б) Баран

Эти примеры, которые тесно связаны с лингвистическим феноменом под названием анафора (явление, когда некоторое выражение обозначает ту же сущность, что и некоторое другое выражение, ранее встретившееся в тексте), представляют трудность, так как требуют здравого смысла — который всё ещё не доступен машинам — и потому что в них встречаются вещи, о которых люди не часто упоминают на web-страницах, а потому эти факты не попадают в гигантские базы данных.

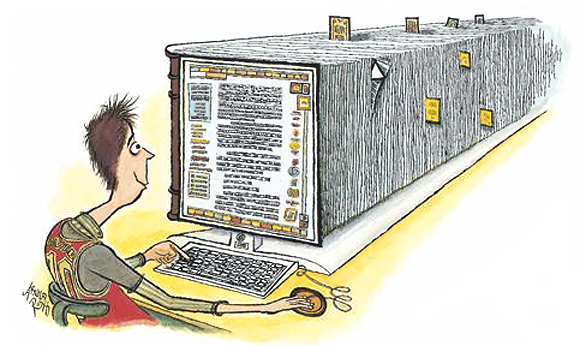

Иными словами, это примеры того, что я люблю называть Проблемой тяжелых хвостов: на обычные вопросы часто можно найти ответ в Сети, но редкие вопросы ставят в тупик весь Веб с его Big Data системами. Большинство программ ИИ сталкиваются с проблемой, если то, что они ищут не встречается в виде точной цитаты на веб-страницах. В этом отчасти заключается одна из причин Самой известной оплошности Watson-а — спутать город Торонто в Канаде с одноименным городом в США.

Аналогичная проблема возникает в поиске изображений, по двум причинам: существует много редких картинок, существует много редких подписей к картинкам. Существует миллионы картинок с подписью «кот»; но поиск Google не может показать почти ничего релевантного по запросу «аквалангист с шоколадной сигаретой» (тонны картинок сигар, нарисованных красоток, пляжей и шоколадных тортиков). При этом любой человек может без труда построить воображаемую картинку нужного аквалангиста. Или возьмём запрос «мужчины правши» («right-handed man»). В Сети уйма изображений правшей, занимающихся каким-либо делом именно правой рукой (например бросание бейсбольного мяча). Любой человек может быстренько извлечь такие картинки из фотоархива. Но очень немногие такие картинки подписаны словом «правша» («right-handed-man»). Поиск же по слову «правша» выдаёт на гора огромное количество картинок спортивных звезд, гират, гольф клубов, связок ключей и кружек с кофе. Некоторые соответствуют запросу, но большинство — нет.

Левек приберёг свои самые критические замечания к концу доклада. Его беспокойство не в том, что современный искусственный интеллект не умеет решать подобного рода проблемы, а в том, что современный искусственный интеллект совершенно о них забыл. С точки зрения Левека, разработка ИИ попала в ловушку «сменяющихся серебряных пуль» и постоянно ищет следующего большого прорыва, будь то экспертные системы или BigData, но все едва заметные и глубокие знания, которыми владеет каждый нормальный человек, никогда скрупулёзно не анализировались. Это колоссальная задача — «как уменьшение горы вместо прокладки дороги», пишет Левек. Но это именно то, что надо сделать исследователям.

В сухом остатке, Левек призвал своих коллег перестать вводить в заблуждение. Он говорит: «Предстоит многого достичь, определив, что именно не попадает в область наших исследований, и признать, что могут понадобиться другие походы». Иными словами, пытаться соревноваться с человеческим интеллектом, без осознания всей запутанности человеческого разума, это как просить аллигатора пробежать стометровку с барьерами.

От переводчика

Меня заинтересовал критический взгляд Левека на современные Siri и Google. Интеллектуальные поисковые системы отлично научились имитировать понимание вопроса, который задают пользователи. Но они всё ещё бесконечно далеки от того ИИ, про который снимают фильмы и пишут книги.

Автор: sheknitrtch