Привет, на связи Елена Кузнецова, специалист по автоматизации Шерпа Роботикс. Сегодня я перевела для вас статью, в которой представлены результаты исследования многозадачных больших языковых моделей и показано, как с их помощью можно не потерять в эффективности и сэкономить вычислительные мощности.

В промышленной индустрии множество задач обработки естественного языка (NLP) развертываются онлайн, и все задачи должны выполняться своевременно и с высокой точностью. По мере увеличения числа задач растет и потребность в ресурсах. Предотвращение линейного роста требований к ресурсам с увеличением числа задач становится одной из самых важных задач для экономии средств.

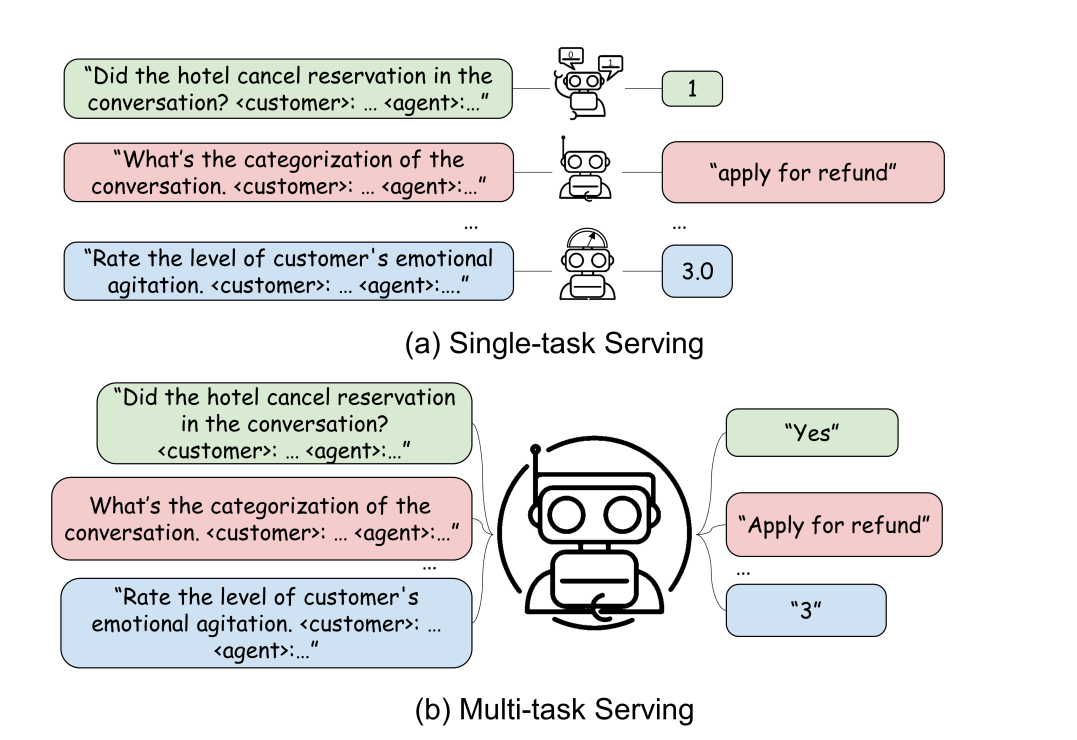

Традиционные подходы решают каждую задачу отдельно, используя свою собственную сеть. Это приводит к чрезмерной нагрузке на разработку и обслуживание, а также к увеличению задержки и потребления ресурсов. Более того, в контексте больших языковых моделей (LLM) это может также привести к чрезмерным затратам на масштабирование моделей для каждой задачи. Мы предлагаем использовать многозадачное обслуживание для развертывания LLM вместо однозадачного обслуживания. Однозадачное и многозадачное обслуживание — это два типа стратегий онлайн-обслуживания, и их парадигмы показаны на рисунке 1. По сравнению с однозадачным обслуживанием, многозадачное обслуживание сокращает усилия по развертыванию и экономит больше памяти благодаря механизму совместного использования, тем самым уменьшая расточительное использование ресурсов.

Однако в реальных приложениях методы многозадачного обучения часто не могут сравниться по производительности с методами однозадачного обучения из-за дисбаланса данных и гетерогенности задач. Дисбаланс данных постоянно приводит к переобучению на задачах с ограниченными ресурсами. Это происходит потому, что преждевременная остановка обучения не является жизнеспособным решением для задач с большим количеством ресурсов; этим задачам требуется гораздо больше эпох для сходимости. Кроме того, гетерогенность может привести к негативному переносу между задачами. Разные задачи требуют разных направлений градиента при оптимизации модели, и слишком сильно различающиеся задачи могут конфликтовать в плане направления градиента.

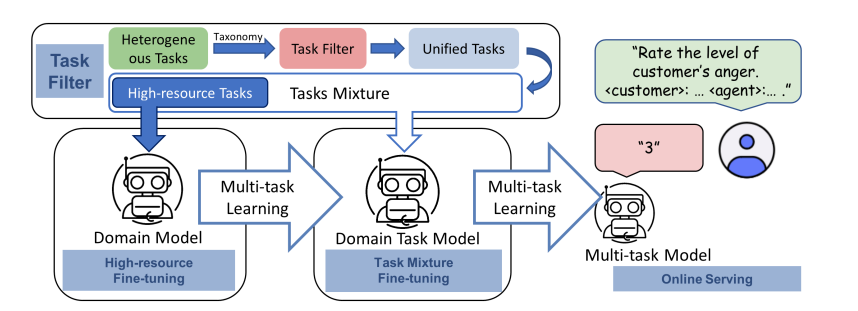

В данной статье авторы предлагают трехэтапную схему: фильтрацию несовместимых задач, донастройку на задачах с большим объемом ресурсов и донастройку на смеси всех задач. Стратегия фильтрации задач предотвращает негативный перенос между гетерогенными задачами. Стратегия донастройки на задачах с большим объемом ресурсов, за которой следует донастройка на смеси, эффективно позволяет использовать преждевременную остановку обучения, позволяя различным задачам иметь различное количество эпох обучения, тем самым предотвращая переобучение задач с ограниченными ресурсами или недообучение задач с большим объемом ресурсов.

В ходе обширного эмпирического исследования исследователи обнаружили, что их алгоритм достигает более близкой к однозадачной настройке производительности по сравнению с другими базовыми моделями многозадачного обучения. Авторы отметили, что улучшение производительности многозадачного обучения в основном обусловлено стратегией выборки, фильтрацией задач и предметно-ориентированным непрерывным предварительным обучением.

Основной вклад исследования можно суммировать следующим образом.

1. Авторы предложили схему многозадачного обслуживания, использующую большие языковые модели (LLM) для реализации многозадачного метода, который одновременно обрабатывает несколько задач и достигает производительности, сопоставимой с производительностью однозадачного метода.

2. Исследователи провели комплексный набор экспериментов, которые показывают, что предложенная схема практична для различных эталонных тестов и способна заменить задачи, обученные в режиме однозадачного обучения. Авторы исследования также провели обширные эксперименты, чтобы оценить важность каждого из компонентов системы, таких как стратегия выбора и выборки задач.

3. Модель была развернута в промышленную эксплуатацию для обслуживания в общей сложности 11 задач. По сравнению с однозадачным обслуживанием, данная модель достигает сопоставимой производительности. В целом, система может снизить общие затраты на обслуживание до 90,9% по сравнению с однозадачным обслуживанием.

Стратегии выборки

Авторы исследования выделили распространенные стратегии выборки, направленные на перебалансировку распределения задач.

Выборка с балансировкой по экземплярам.

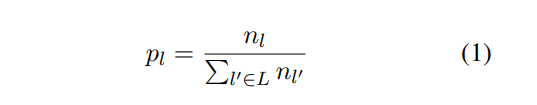

Выборка с балансировкой по экземплярам подразумевает выборку примеров из каждой задачи на основе общего размера набора данных каждой задачи. В частности, эмпирические распределения для различных задач выглядят следующим образом.

Выборка с балансировкой по классам.

Выборка с балансировкой по классам подразумевает выборку примеров из каждой задачи с равной вероятностью. В каждой батче каждый пример выбирается равномерно из одной из задач, используемых для обучения.

Выборка с температурной шкалой.

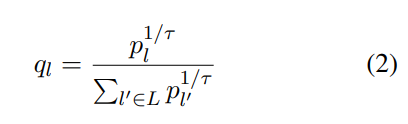

Выборка с температурной шкалой подразумевает перемасштабирование частот выборки с помощью температуры τ. Она использует распределение q, определяемое возведением p в экспоненту.

Затем была проведена многозадачная донастройка на задачах с большим объемом ресурсов. После этого авторы произвелимногозадачную донастройку на всех задачах, позволяя модели обучаться на смеси задач одновременно. Наконец, многозадачная модель разворачивается онлайн для обслуживания различных задач.

Комментарий

Многозадачные языковые модели открывают нам большие перспективы для новых способов использования. При снижении требований к вычислительным мощностям, у нас появится больше возможностей для автоматизации всё новых и новых процессов.

Автор: lenasherparpa