Уходящий 2022-ой год, стал, безусловно, межевым для отечественной микроэлектроники. Введенные санкции лишили российские дизайн-центры доступа к заводам по производству разрабатываемой ими продукции, в первую очередь, к мощностям флагмана отрасли в лице тайваньской компании TSMC. Фактически, это означает, что на данный момент в России становится невозможным производить сколь либо современную кремниевую микроэлектронику, особенно в части высокопроизводительных решений. Краткий профессиональный разбор ситуации с обзором наших текущих возможностей ещё в марте этого года сделал уважаемый @CorneliusAgrippa. Если резюмировать – на данный момент Россия имеет возможность промышленно производить чипы по технологии 180 нм на заводе Микрон, с перспективой наладить 90 нм в ближайшее время (правительство поставило задачу сделать это до конца 2022-го года). Создание на имеющейся на Микроне линии промышленной технологии на 65 нм и ниже фактически невозможно. Причина в том, что завод Микрон работает на пластинах диаметра 200 мм, а технология производства на 65 нм сопровождалась параллельным переходом на пластины диаметром 300 мм. Поэтому, для такого перехода требуется, по сути, постройка нового завода, хотя имеющееся на Микроне литографическое оборудование потенциально позволяет создание 65 нм техпроцесса.

В то же время в публичном пространстве постоянно появлялись публикации, которые пытались представить сложившуюся ситуацию в достаточно розовых тонах, начиная от программных заявлений нового руководителя РАН (разбор тут) до откровенной идиотии в виде бравурных фантазий исполнительного директора консорциума РосСХД. Причём данные заявления выходили не в каких-то жёлтых СМИ или частных каналах блогеров, а во вполне респектабельных изданиях. Такого рода информационные заряды (но не только они, конечно же) приводят к тому, что в обществе циркулирует большое количество заблуждений относительно реального масштаба проблем в отечественной индустрии микроэлектроники. В данной статье я пройдусь по тем основным мифам, которые регулярно всплывают в информационном пространстве и вводят в заблуждение людей, не столь глубоко погруженных в вопрос.

Закон Мура давно умер, современные нанометры – лишь пиар!

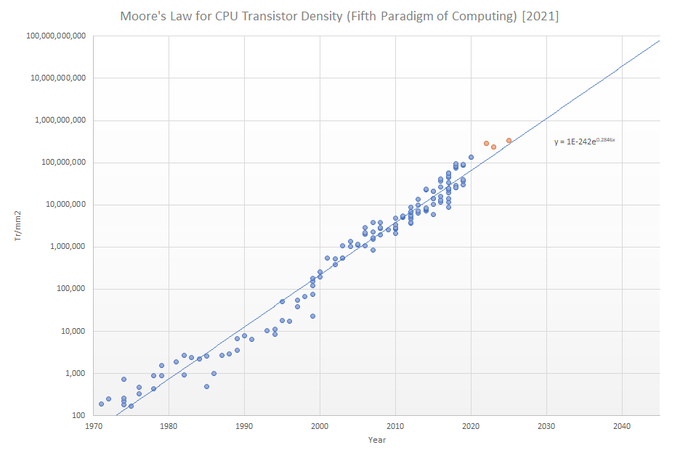

Данный тезис регулярно всплывает в различных обсуждениях, но чтобы понять, что закон Мура до сих пор работает, достаточно просто взглянуть на данный график:

Дело в том, что люди зачастую путают закон Мура с Масштабированием Деннарда.

Последнее действительно перестало работать примерно в середине 2000х, что в том числе привело резкому замедлению роста частоты процессоров при переходе на более современный техпроцесс. Но данный факт не означает того, что производительность микропроцессоров перестала расти (об этом ниже).

Что касается «нанометров» - то тут надо понимать, что закон Мура не говорит о размере транзисторов, а лишь о количестве транзисторов на единицу площади. И то, что в современных техпроцессах «размер» транзистора действительно не соответствует заявленным 7-5-3 нм, не отменяет того, что плотность транзисторов продолжает расти в соответствии с законом Мура. И это даёт существенные преимущества при разработке чипов на более совершенных нанометрах

Кремний закончился, мы достигли предела!

Разговоры о пределе кремниевой микроэлектроники я помню ещё начиная где-то с 90 нм. Но в итоге, в 2022-ом году компании Samsung и TSMC запускают производство по 3 нм техпроцессу.

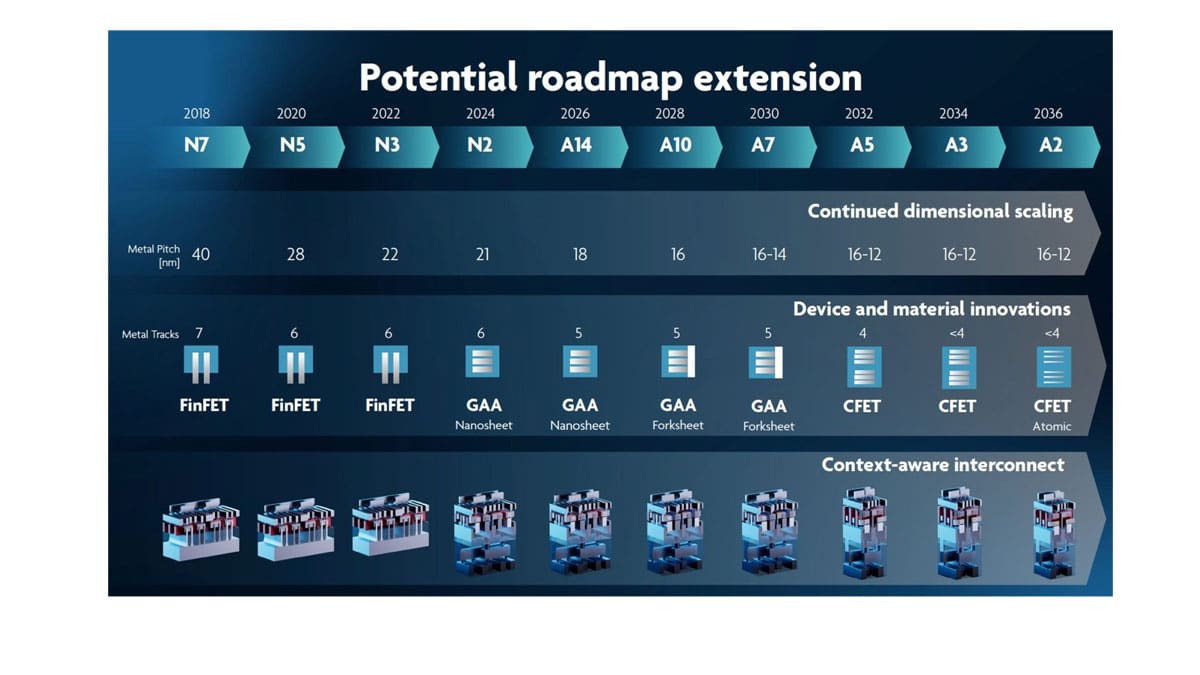

Вот слайд с презентации от IMEC (наверное, ведущего в мире научно-исследовательского центра в области разработки технологий по созданию «тонких» нанометров) :

Как видно, до 2036-го года смерть кремниевой микроэлектроники не предвидится и к тому времени планирует достичь техпроцесса А2 (т.е. 0.2 нм).

Интересующимся, чуть подробнее можно почитать здесь: Imec Presents Sub-1nm Process and Transistor Roadmap Until 2036: From Nanometers to the Angstrom Era.

Львиная доля чипов делается по техпроцессу 90 нм и выше! Тонкие нанометры нужны только в мобильных телефонах, а в остальных применениях вполне достаточно и 90 нм.

Данный тезис, наверное, является одним из основных фиговых листков, которым не очень компетентные (или очень предвзятые) деятели пытаются прикрыть масштаб проблемы сложившейся ситуации.

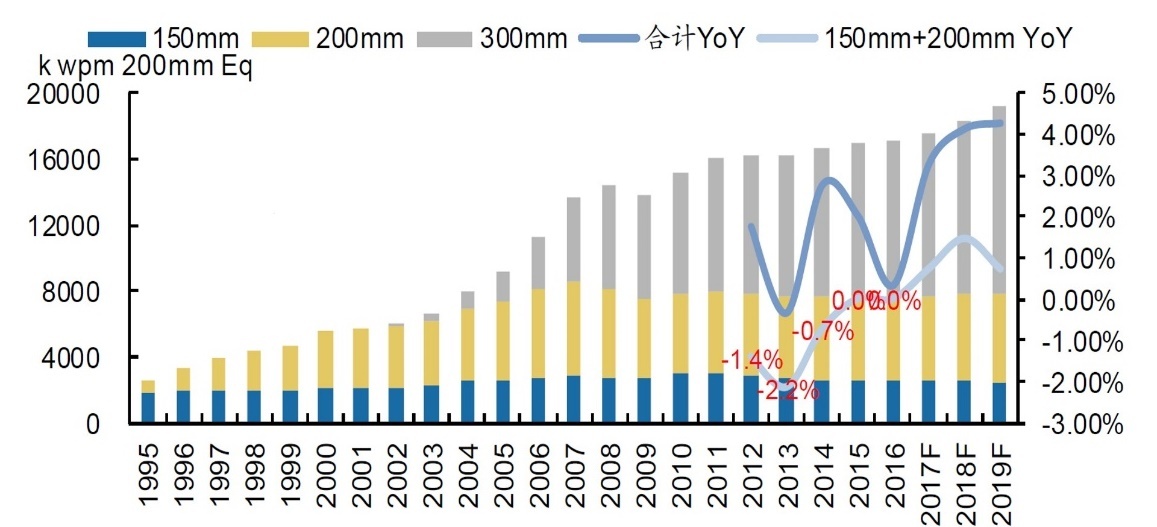

Для начала разберёмся с «львиной долей» и просто посмотрим на следующий график (взято отсюда):

Он показывает распределение, какое количество пластин разного размера используется для производства чипов (нормировано в эквиваленте 200 мм пластин). Это распределение нам полезно тем, что, как мы помним, пластины 300 мм в основном используются для 65 нм и ниже и мы можем примерно оценить долю производства на 90+ нм.

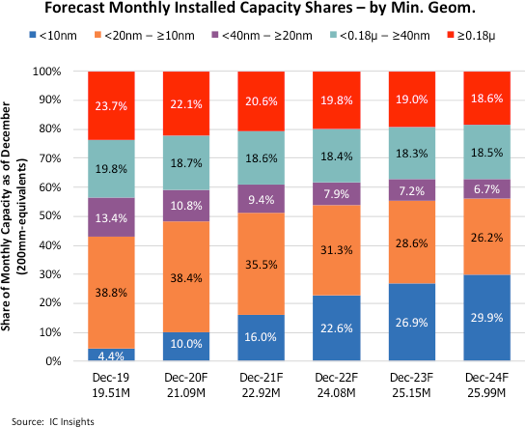

Примерно схожую картину рисует нам распределение по установленным производственным мощностям в зависимости от нанометров:

Таким образом можно сделать вывод, что на данный момент порядка ~70% чипов производится на техпроцессах не хуже 65 нм. Ещё ~10% приходится на 90-130 нм, и лишь оставшиеся ~20% на 180+ нм.

Теперь что касается того, где нужны тонкие нанометры и какие преимущества они дают. В табличках ниже я собрал примерную статистику о характеристиках и производительности процессоров Intel и видеопроцессоров/GPGPU от компании Nvidia. За ориентир брались близкие к топовым решения, чтобы было понятно, какой уровень производительности можно достичь на данном техпроцессе.

Производительность процессоров Intel на бенчмарке Spec2006. В случае отсутствия результатов на сайте spec.org, значения получены аппроксимацией результатов на тесте CPUMark (для Pentium III) или Spec2017 (для Core i9-11900K и Core i9-12900K):

|

Node (Intel) |

Year |

Name |

CPU clock, GHz |

Transistors, mln |

Die size, mm^2 |

Cores |

SpecInt 2006,1T |

SpecFP 2006,1T |

|

180 nm |

2000 |

Pentium III (Coppermine) |

1.1 |

29 |

106 |

1 |

5 |

5 |

|

90 nm |

2005 |

Pentium 4 processor 670 |

3.8 |

169 |

135 |

1 |

12.2 |

11.5 |

|

65 nm |

2007 |

Core 2 Duo E6850 |

3.0 |

291 |

143 |

2 |

20.2 |

18.7 |

|

45 nm |

2009 |

Core i7-960 |

3.5 |

731 |

263 |

4 |

36.3 |

41.9 |

|

32 nm |

2011 |

Core i7-2600K |

3.8 |

1160 |

216 |

4 |

47.3 |

55.0 |

|

22 nm |

2014 |

Core i7-4790K |

4.4 |

1400 |

177 |

4 |

65.4 |

77.7 |

|

14 nm |

2015 |

Core i7-6700K |

4.2 |

1750 |

122 |

4 |

70.7 |

94.8 |

|

14 nm |

2021 |

Core i9-11900K |

5.3 |

~6000 |

276 |

8 |

82.3 |

183.2 |

|

10 nm (Intel7) |

2021 |

Core i9-12900K P-core |

5.2 |

~8000 |

215 |

8+8 |

97.5 |

220.0 |

Из вышеприведенных цифр видно, что несмотря на то, что начиная с 90 нм рост частоты резко замедлился (а иногда даже откатывался немного назад), производительность одного ядра процессоров Intel неизменно росла и для последних моделей на техпроцессе Intel 7 составила ~8x для целочисленных задач и ~19x для плавающих по сравнению с Pentium 4 на 90 нм. Если же учитывать различие в количестве ядер на чипе, то разница вырастет ещё на порядок.

Теперь производительность видеопроцессоров/GPGPU от компании Nvidia:

|

Node (TSMC) |

Year |

Name |

GPU clock, MHz |

Transistors, mln |

Die size, mm^2 |

Pixel Rate, GP/s |

Texture Rate, GT/s |

FP32, GFlops |

FP64, GFlops |

|

180 nm |

2000 |

GeForce2 MX 400 |

200 |

20 |

64 |

0.4 |

0.8 |

|

|

|

90 nm |

2006 |

GeForce 7900 GTO |

650 |

278 |

196 |

10.4 |

15.6 |

|

|

|

65 nm |

2008 |

GeForce GTX 280 |

602 |

1400 |

576 |

19.6 |

48.16 |

622 |

78 |

|

40 nm |

2010 |

GeForce GTX 580 |

772 |

3000 |

520 |

37.05 |

49.1 |

1581 |

198 |

|

28 nm |

2015 |

GTX TITAN X |

1089 |

8000 |

601 |

104.5 |

209.1 |

6691 |

209 |

|

16 nm |

2017 |

GTX 1080 Ti |

1582 |

11800 |

471 |

139.2 |

354.4 |

11340 |

354 |

|

12 nm |

2018 |

TITAN RTX |

1770 |

18600 |

754 |

169.9 |

509.8 |

16312 |

510 |

|

4 nm |

2022 |

GeForce RTX 4090 |

2520 |

76300 |

608 |

443.5 |

1290 |

82580 |

1290 |

Здесь наблюдается ещё более драматичная картина. Если усреднить различные характеристики, то можно говорить о преимуществе на 2 порядка самых современных моделей по сравнению с 90 нм версиями. И это без учёта наличия новых функциональных возможностей по поддержке AI-вычислений, Ray Tracing’a и т.д.

Как видим, «тонкие» нанометры дают преимущества далеко не только для создания мобильных процессоров.

Топовые процессоры не нужны – это лишь маркетинг!

Парадоксально, но многие всерьёз считают, что более производительные процессоры не особо-то и нужны.

Безусловно, для секретарш, коротающих свой рабочий день за раскладкой косынки, это утверждение может быть вполне верно. Но, к сожалению, есть огромное количество применений микроэлектроники, где это совершенно не так. Давайте обзорно пройдёмся по некоторым из тех применений микропроцессоров, где производительность существенно важна, и к чему приведёт гипотетический переход с современной техники на процессоры, разработанные по технологии 90 нм.

Десктопы/ноутбуки:

-

Банальный сёрфинг по современному интернету требует приличной производительности процессоров. Если web-страницы будут загружаться не условных 5 секунд, а порядка 1 минуты, можете сами посчитать, на сколько это снизит производительность рабочего процесса

-

Разработчикам ПО придётся ждать сборку своих проектов на порядок дольше. Что соответствующе увеличит сроки разработки

-

Пострадают все пользователи сложного специализированного, инженерного, математического ПО, программ 3D-моделирования и т.д.

-

Современные соцсети, видео, онлайн конференции станут малопригодными к использованию (хотя в этом кто-то увидит определённые плюсы)

-

Собственно, практически любые действия, которые раньше занимали незаметные 2-3 секунды на компьютере, теперь будут исполняться десятки секунд, или даже минуты

Сервера:

Здесь ситуация ещё более критическая:

-

Базы данных снизят свою производительность на порядок, что как минимум потребует пропорционально увеличить количество используемых машин

-

Аналогичная ситуация для всего сайтов, видео, аудио и т.д.

-

Собственно, все сложные, оптимизированные и высоконагруженные системы, являющиеся основой цифровизации, требуют максимальной производительности и также потребуют кратного увеличения мощностей с неизбежной потерей качества сервисов по многим аспектам

-

Системы тестирования/разработки как ПО, так и любых промышленных изделий, завязанные на использование серверных мощностей, пострадают таким же образом

-

Про отрасль суперкомпьютеров со всякими критически важными обсчётами можно будет забыть, т.к. время работы алгоритмов вырастет катастрофически

-

Big data, AI, 5G – все эти абревиатуры требуют максимально возможной производительности. Собственно, цифры роста производительности для решений от Nvidia выше, как раз во многом и есть отображение прогресса в данных отраслях.

Как можно видеть, отсутствие доступа к современным процессорам бьёт в первую очередь по возможности проведения передовых научно-технических исследований, созданию высокотехнологичных производств/изделий, и построению развитой экономики, способной эти самые исследования и производства обеспечить. Несложно догадаться, к чему приведёт такая ситуация на длинной дистанции.

И поэтому неудивительно, что санкции и ограничения, вводимые Западом против России/Китая, нацелены в первую очередь на передовые техпроцессы.

Отставание в нанометрах можно нивелировать оптимизацией софта. Ведь у нас самые лучшие программисты в мире! Они этим и займутся.

Этот забавный аргумент мне доводилось слышать из уст даже вполне себе технических специалистов, которых сложно заподозрить в предвзятости.

Во-первых, данный аргумент страдает очевидным логическим изъяном – если вы смогли оптимизировать ПО для медленного процессора на толстых нанометрах, вполне очевидно, что данный софт также станет работать быстрее и на более современном процессоре. Т.е. отставание таким образом вы никак не сократите. Безусловно, есть сложные микроархитектурные особенности чипов, которые позволяют данному правилу иногда не соблюдаться, но это как раз те самые исключения, которые подтверждают правило.

Во-вторых, те участки кода, которые активно работают на железе и занимают основную долю процессорной нагрузки – как раз в основном оптимизированы очень хорошо. Зрелые языки программирования, такие как C/C++, Python, Java, Javascript, C# и т.д. имеют крайне развитую экосистему библиотек, которая оптимизировалась десятилетиями (а зачастую именно в библиотеках мы проводим большую часть времени работы). Улучшить там что-то даже на проценты – уже задача не из лёгких. Аналогичная ситуация для основополагающего для современной ИТ-инфраструктуры ПО в виде операционных систем, компиляторов, баз данных, виртуальных машин, различного рода серверных движков, работающих в крупных датацентрах – это ПО оптимизировалось годами самыми топовыми экспертами в данных областях. Рассчитывать на радикальную оптимизацию чего-либо там – крайне наивно.

Безусловно, есть кривые архитектуры и плохо написанный код, нерадивые программисты и ленивые сисадмины. Но как правило, это в основном относится как раз к тому софту, скорость работы которого не особо важна, и именно поэтому потребности в его оптимизации не возникало. Там же, где производительность была важна – ПО скорее всего будет вполне прилично оптимизировано.

И в третьих, не стоит забывать, что оптимизация кода, тем более на уровне алгоритмов или рефакторинга архитектуры – задача, посильная достаточно узкому кругу программистов. Учитывая, что прямо в данный момент у нас стоит задача по банальному замещению огромного количества ПО (под что уже требуется большое количество разработчиков), проводить массовую оптимизацию всего стэка существующего ПО абсолютно нереалистично. Под это не хватит никаких ресурсов, даже если вся страна пойдёт в программисты.

В военке и космосе тонкие нанометры не нужны, 90 нм вполне достаточно!

Наверное, одно из самых распространённых заблуждений. По всей видимости, его основой является обывательское представление о том, что «чем толще, тем надёжнее» и «ракеты и в СССР отлично летали». Про радиационно стойкие микросхемы для космоса на хабре уже не раз были разборы от людей, понимающих в вопросе куда глубже, например, вот статья от @amartology а вот статья от @BarsMonster Там, на мой взгляд, достаточно подробно разобран миф о необходимости «толстых» нанометров в «космических» чипах. Если вкратце – то тонкие нанометры, в общем-то, в космосе также нужны, как и на Земле.

А вот про военную тематику поговорим немного подробнее.

В целом, всю историю человечества военные разработки всегда были на передовой прогресса и зачастую множество технологий сначала проходили путь апробации в военной сфере, и лишь потом доходили до гражданского рынка. Микроэлектроника тут совсем не исключение – люди в погонах всегда были первыми потребителями самых передовых разработок в отрасли. Так было и в США, так было и в СССР. Каким образом размышляют люди, утверждающие, что на 90 нм прогресс в военной сфере должен был остановиться – для меня совершенная загадка. Ведь достаточно взглянуть на современную номенклатуру вооружений – сложные системы ПВО, связи, РЭБ, напичканные электроникой самолёты, корабли, подводные лодки – всё это, вполне очевидно, требует серьёзных вычислительных мощностей. И проигрыш оппоненту долей секунды может быть фатальным в этой гонке.

Вот последние новости, согласно которым US Department of Defense (то бишь министерство обороны США) стало первым заказчиком на новой строящейся фабрике Intel, планирующей производить чипы по техпроцессу A18 (т.е. 1.8 нм):

The U.S. Department of Defense (DoD) is Intel Foundry Services’ (IFS’s) “No. 1” customer, IFS president Randhir Thakur told EE Times, noting that IFS plans to be part of the DoD state-of-the-art heterogeneous integrated packaging (SHIP) program. That program will necessitate deep knowledge of gate-all-around (GAA) technology facilitating high-transistor–density 3D chips.

Intel’s new foundry unit has an initial $250 million contract with the DoD to provide chip design and development. The next step, for a much larger and unnamed dollar figure, will include manufacturing if IFS can meet certain national security criteria, Thakur said in an interview on the sidelines of Intel’s latest fab project in Columbus, Ohio.

Особенное беспокойство здесь должен вызывать тот колоссальный прогресс, который был достигнут в области искусственного интеллекта за последнее десятилетие. Он во многом связан именно с развитием техпроцессов производства чипов, вышеприведённая табличка роста производительности чипов от Nvidia как раз и отображает произошедший рывок. Производительность специализированных AI-процессоров, в силу особенности их вычислений, достаточно хорошо масштабируется к количеству транзисторов, которых можно разместить на чипе. Поэтому, при прочих равных, AI-процессор, произведённый по 90 нм техпроцессу, будет уступать его А18 собрату примерно в 2500 раз. Я думаю, никто не возьмётся спорить, что такой разрыв в характеристиках в разрезе военного применения может привести к катастрофическим последствиям.

Показательно, что введённые недавно США санкции против Китая нацелены как раз на ограничение возможности создания именно передовых AI-чипов, в области чего у Поднебесной наметились большие успехи в последние годы. Желающие изучить вопрос более подробно могут почитать здесь.

Резюмируя – имеющиеся в России производственные мощности в части микроэлектроники являются, со всей очевидностью, устаревшими, и не могут обеспечить базовые потребности страны ни в гражданском, ни в военном секторах. Это необходимо чётко осознать и озвучить, а не рассказывать сказки про «достаточно и 90нм».

Автор: Максим Маслов