IEEE P802.3ba, стандарт для передачи данных по 100-гигабитным каналам Ethernet (100GbE), разрабатывался в период с 2007 по 2010 год [3], но получил широкое распространение только в 2018 [5]. Почему именно в 2018, а не раньше? И почему сразу в массовом порядке? На то есть как минимум пять причин...

Разрабатывался IEEE P802.3ba, в первую очередь, для удовлетворения нужд ЦОД и нужд точек обмена интернет-трафиком (между независимыми операторами); а также для обеспечения бесперебойной работы ресурсоёмких веб-сервисов, таких как порталы с большим количеством видео-контента (например, YouTube); и для осуществления высокопроизводительных вычислений. [3] Рядовые пользователи Интернета тоже вносят свой вклад в изменение требований к пропускной способности: у многих есть цифровые камеры, и люди хотят передавать отснятый ими контент через Интернет. Т.о. объём циркулирующего по Интернету контента с течением времени становится всё больше и больше. Как на профессиональном, так и на потребительском уровнях. Во всех этих случаях, при передаче данных из одного домена в другой, совокупная пропускная способность ключевых сетевых узлов, уже давно превышает возможности портов 10GbE. [1] Этим и обусловлено появление нового стандарта: 100GbE.

Крупные ЦОД и поставщики облачных услуг уже активно применяют 100GbE, и планируют через пару лет постепенно переходить на 200GbE и 400GbE. При этом уже присматриваются к скоростям, превышающим терабит. [6] Хотя есть среди крупных поставщиков и такие, которые переходят на 100GbE лишь только в прошлом году (например, Microsoft Azure). ЦОД, осуществляющие высокопроизводительные вычисления для финансовых услуг, государственных платформ, нефтегазовых платформ и коммунальных услуг, – также начали переходить на 100GbE. [5]

В корпоративных ЦОД потребность на пропускную способность несколько ниже: лишь недавно 10GbE стала здесь насущной необходимостью, а не роскошью. Однако, поскольку темпы потребления трафика растут всё стремительней, сомнительно, что 10GbE проживёт в корпоративных ЦОД хотя бы 10 или даже 5 лет. Вместо этого мы увидим быстрый переход на 25GbE и ещё более быстрый на 100GbE. [6] Потому что, как отмечают аналитики Intel, интенсивность трафика внутри ЦОД ежегодно увеличивается на 25%. [5]

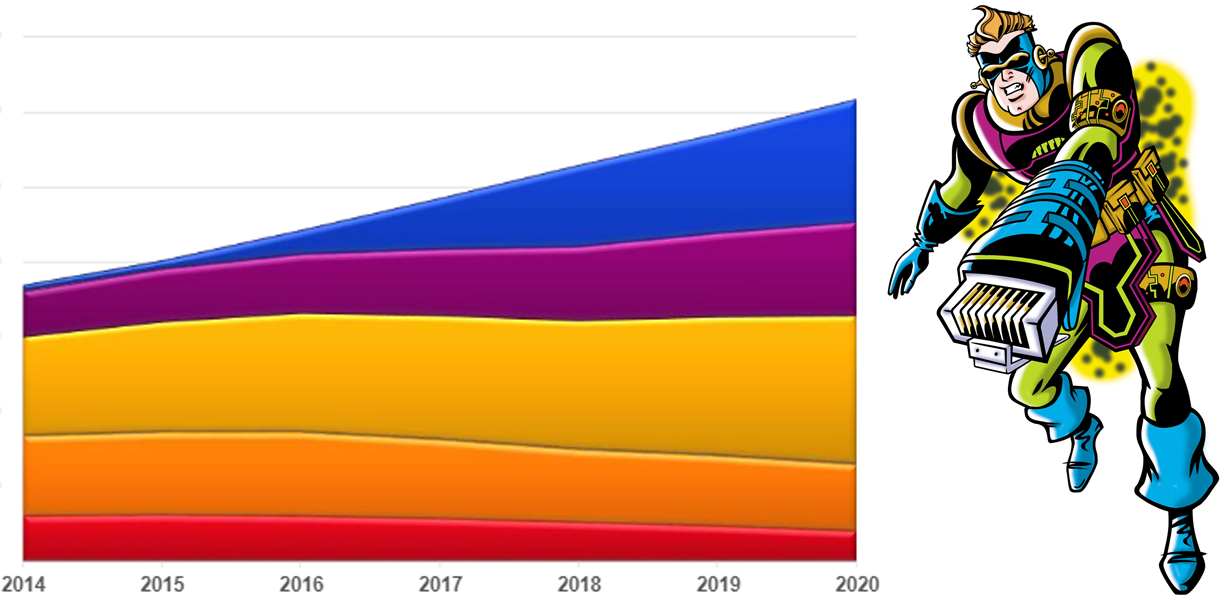

Аналитики Dell и Hewlett Packard констатируют [4], что 2018-й год – это год 100GbE для ЦОД. Ещё в августе 2018-го года поставки оборудования 100GbE вдвое превысили поставки за весь 2017-й год. И темпы поставок продолжают расти, поскольку ЦОД начали в массовом порядке отходить от 40GbE. Ожидается, что к 2022 году ежегодно будет поставляться 19,4 млн. 100GbE-портов (в 2017, для сравнения, эта цифра составляла 4,6 млн.). [4] Что касается затрат, то в 2017 году на 100GbE-порты было потрачено $7 млрд., а в 2020-м, по прогнозам, будет потрачено порядка $20 млрд (см. рис. 1). [1]

Рисунок 1. Статистика и прогнозы спроса на сетевое оборудование

Почему сейчас? 100GbE не такая уж и новая технология, так почему именно сейчас вокруг неё разворачивается такой ажиотаж?

1) Потому что эта технология созрела и подешевела. Именно в 2018 году мы перешагнули тот рубеж, когда использование в ЦОД платформ со 100-гигабитными портами стало более рентабельным, чем «штабелирование» нескольких 10-гигабитных платформ. Пример: Ciena 5170 (см. рис. 2) – компактная платформа, обеспечивающая совокупную пропускную способность в 800GbE (4x100GbE, 40x10GbE). Если для обеспечения необходимой пропускной способности требуется несколько 10-гигабитных портов, то затраты на дополнительное железо, дополнительно занимаемое пространство, избыточное потребление электроэнергии, текущее обслуживание, дополнительные запчасти и дополнительные системы охлаждения, – складываются в достаточно кругленькую сумму. [1] Так например, специалисты Hewlett Packard, анализируя потенциальные преимущества перехода от 10GbE к 100GbE пришли к следующим цифрам: производительность выше (на 56%), суммарные затраты меньше (на 27%), меньше потребление электроэнергии (на 31%), упрощение кабельных взаимосвязей (на 38%). [5]

Рисунок 2. Ciena 5170: пример платформы со 100-гигабитными портами

2) Juniper и Cisco наконец-то создали свои собственные микросхемы ASIC для коммутаторов 100GbE. [5] Что является красноречивым подтверждением того факта, что технология 100GbE – действительно созрела. Дело в том, что микросхемы ASIC рентабельно создавать только тогда, когда, во-первых, реализуемая на них логика – не потребует изменений, в обозримом будущем, и во-вторых, когда изготавливается большое количество идентичных микросхем. Juniper и Cisco не стали бы производить эти ASIC, не будучи уверенными в зрелости 100GbE.

3) Потому что Broadcom, Cavium, и Mellanox Technologie начали штамповать процессоры с поддержкой 100GbE, и эти процессоры уже используются в коммутаторах таких производителей, как Dell, Hewlett Packard, Huawei Technologies, Lenovo Group и др. [5]

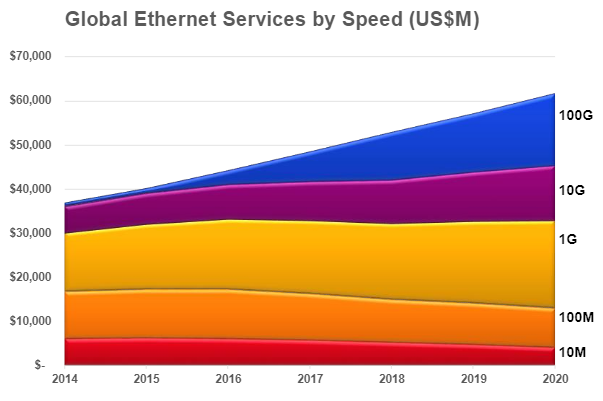

4) Потому что серверы, размещённые в серверных стойках, всё чаще оснащаются новейшими сетевыми адаптерами Intel (см. рис. 3), с двумя 25-гигабитными портами, а иногда даже конвергентными сетевыми адаптерами с двумя 40-гигабитными портами (XXV710 и XL710). {Рисунок 3. Новейшие сетевые адаптеры Intel: XXV710 и XL710}

5) Потому что оборудование 100GbE имеет обратную совместимость, что упрощает развёртывание: можно повторно использовать уже проброшенные кабели (достаточно подключить к ним новый приёмо-передатчик).

Кроме того, доступность 100GbE подготавливает нас к новым технологиям, таким как «NVMe over Fabrics» (например, Samsung Evo Pro 256 GB NVMe PCIe SSD; см. рис. 4) [8, 10], «Storage Area Network» (SAN) / «Software Defined Storage» (см. рис. 5) [7], RDMA [11], которые без 100GbE не могли реализовать свой потенциал в полной мере.

Рисунок 4. Samsung Evo Pro 256 GB NVMe PCIe SSD

Рисунок 5. «Storage Area Network» (SAN) / «Software Defined Storage»

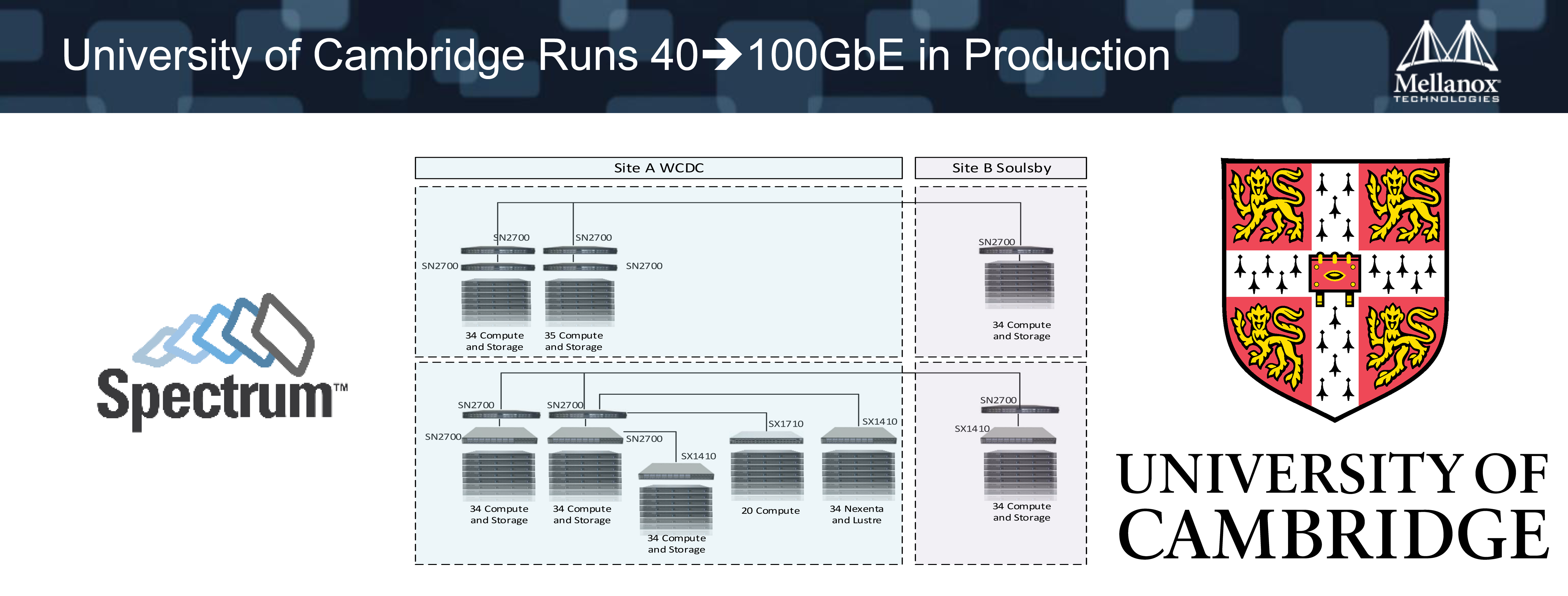

Наконец, в качестве экзотического примера практической востребованности применения 100GbE и смежных высокоскоростных технологий, можно привести научное облако Кембриджского университета (см. рис. 6), которое построено на основе 100GbE (Spectrum SN2700 Ethernet switches), – для того чтобы, в числе прочего, обеспечивать эффективную работу распределённого дискового хранилища NexentaEdge SDS, которое легко может перегрузить сеть 10/40GbE. [2] Подобные высокопроизводительные научные облака разворачивают для решения самых разнообразных прикладных научных задач [9, 12]. Так например, учёные-медики задействуют такие облака для расшифровки генома человека, а каналы 100GbE используют для передачи информации между исследовательскими группами университетов.

Рисунок 6. Фрагмент научного облака Кембриджского университета

- John Hawkins. 100GbE: Closer to the Edge, Closer to Reality // 2017.

- Amit Katz. 100GbE Switches – Have You Done The Math? // 2016.

- Margaret Rouse. 100 Gigabit Ethernet (100GbE).

- David Graves. Dell EMC Doubles Down on 100 Gigabit Ethernet for the Open, Modern Data Center // 2018.

- Mary Branscombe. The Year of 100GbE in Data Center Networks // 2018.

- Jarred Baker. Moving Faster in the Enterprise Data Center // 2017.

- Tom Clark. Designing Storage Area Networks: A Practical Reference for Implementing Fibre Channel and IP SANs. 2003. 572p.

- James O’Reilly. Network Storage: Tools and Technologies for Storing Your Company's Data // 2017. 280p.

- James Sullivan. Student cluster competition 2017, Team University of Texas at Austin/Texas State University: Reproducing vectorization of the Tersoff multi-body potential on the Intel Skylake and NVIDIA V100 architectures // Parallel Computing. v.79, 2018. pp. 30-35.

- Manolis Katevenis. The next Generation of Exascale-class Systems: the ExaNeSt Project // Microprocessors and Microsystems. v.61, 2018. pp. 58-71.

- Hari Subramoni. RDMA over Ethernet: A Preliminary Study // Proceedings of the Workshop on High Performance Interconnects for Distributed Computing. 2009.

- Chris Broekema. Energy-Efficient Data Transfers in Radio Astronomy with Software UDP RDMA // Future Generation Computer Systems. v.79, 2018. pp. 215-224.

PS. Первоначально статья была опубликована в «Системном администраторе».

Автор: KarevAnton