Повальная кластеризация всего и вся требует специфических технологий обмена данными, характеризующихся, прежде всего, низкими задержками и высокой скоростью. Самым известным и используемым в этой области стандартом является Infiniband. Появившись в далеком 1999 году, в процессе своего развития Infiband увеличил свою скорость c 2 до 100 Гбит/с. Компания Intel является участником ассоциации, развивающей Infiband и выпускает Infiband-оборудование. Это, впрочем, не мешает ей своими собственными силами поддерживать еще один стандарт высокоскоростных сетей коммутации — Intel Omni-Path. Это наименование несколько раз появлялось в постах нашего блога, и каждый раз читатели просили подробностей. Теперь у нас есть возможность о них рассказать.

Архитектура Intel Omni-Path

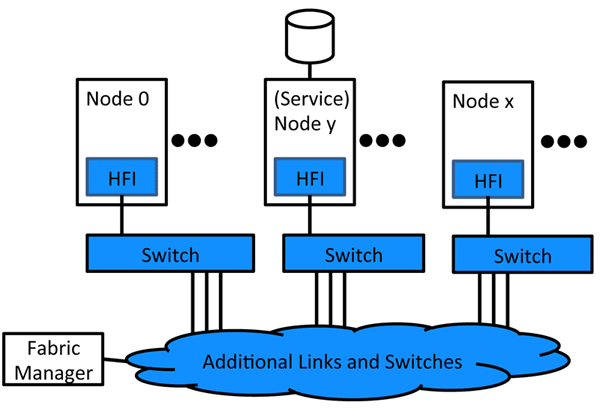

Intel Omni-Path имеет стандартную для технологий подобного рода архитектуру. Ее инфраструктура состоит из сетевых адаптеров (HFI, Host Fabric Interface) для подключения вычислительных и управляющих нод, коммутаторов, позволяющих создать необходимую топологию и количество портов и средства управления для контроля и мониторинга всей фабрики.

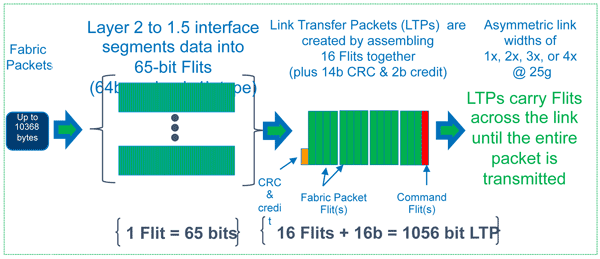

С сетевой точки зрения Omni-Path достаточно точно вписывается в эталонную модель OSI с одним небольшим нюансом: в описании протокола используется термин «полуторный уровень» (LTP, Link Transfer Protocol), отвечающий за надежную доставку объектов второго уровня, контроль потока и соединения. В ведении второго уровня остается адресация, коммутация и выделение ресурсов.

При переходе с второго на полуторный уровень данные нарезаются на 64-битные кусочки, к ним присоединяется бит типа и получается флит (Flit). Единица данных, с которой работает LTP, состоит из 16 флитов, 14 битов CRC и двух отчетных битов. Один или несколько флитов является командным и содержит информацию управляющих протоколов. При необходимости заново передать определенный LTP (Link Transfer Packet) посылается пустой LTP с необходимыми данными в командной части. Отчетные биты 4 последовательных LTP складываются в 8-битный отчет, доставляемый в командном флите.

Оперирование маленькими кусочками данных позволяет держать под контролем задержки передачи, минимизировать их разброс, обеспечивает базу для механизмов QoS. Для ранжирования трафика применяются так называемые «виртуальные линии» (Virtual Lanes). Для адресации абонентов фабрики используется 24-битные идентификаторы.

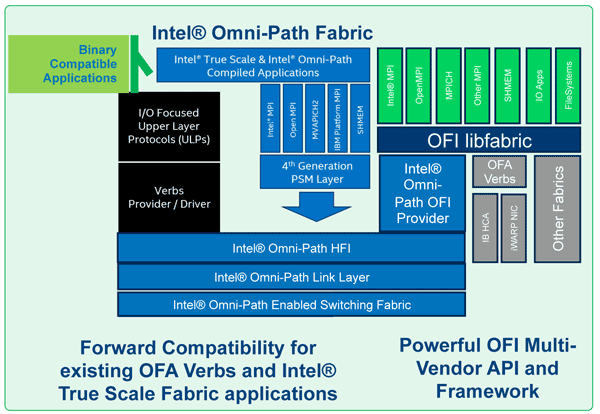

Четвертый и последующий уровни интегрируют Omni-Path в требуемую программную среду. Performance Scaled Messaging (PSM) — API и соответствующий протокол 4 уровня, разработанный для нужд HPC — High Performance Computing. Open Fabrics Interface (OFI) — универсальный фреймворк и программная прокладка для самых различных нужд и протоколов. Open Fabrics Alliance Verbs — API и соответствующий протокол 4 уровня для реализации RDMA (Remote Direct Memory Access).

Оборудование Omni-Path

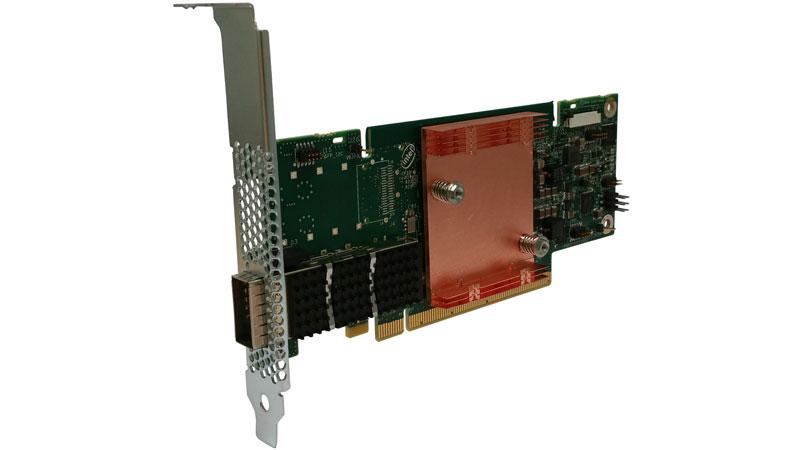

Технология Intel Omni-Path существует не только в виде красивых картинок. В 2015-16 годах Intel выпустила полный набор устройств, необходимых для ее использования на практике. Во-первых, это оконечные адаптеры ноды — HFI. Они существуют двух модификаций: в виде PCI Express карты х8 (максимальная скорость данных 56 Гбит/с) и в виде карты х16 (максимальная скорость данных 100 Гбит/с). Интерфейс подключения — QSFP28. Intel также выпускает QSFP-кабели различной длины, медные пассивные и оптические активные.

Для организации требуемой топологии сети Omni-Path Intel предлагает два вида коммутаторов Intel Omni-Path Edge Switch 100 Series с 24 и 48 100G портами QSFP28. Судя по заявленным характеристикам коммутаторы обеспечивают честный дуплексный 100G на каждый порт без переподписки. Также анонсированы два модульных коммутатора Intel Omni-Path Director Class Switch со значительно большим количеством портов (192 и 768) и существенной переподпиской (утилизация не более 25%).

В планах компании — интеграция контроллеров Omni-Path в процессоры Intel Xeon и активное использование технологии в Xeon Phi. Будем ждать следующих новостей из этой области.

Автор: Intel