В конце прошлого года “искусственный интеллект” многократно упоминали в итогах и прогнозах IT-индустрии. И в нашу компанию, которая занимается информационной безопасностью, всё чаще стали присылать из различных изданий вопросы про перспективы AI. Но эксперты по безопасности не любят комментировать эту тему: возможно, их отталкивает именно эффект “жёлтой прессы”. Легко заметить, как возникают такие вопросы: после очередной новости типа “Искусственный интеллект научился рисовать как Ван Гог” журналисты хватаются за горячую технологию и идут опрашивать по ней всех подряд – а чего может достичь AI в животноводстве? А в сфере образования? Где-то в этом списке автоматически оказывается и безопасность, без особого понимания её специфики.

Кроме того, журналистика, щедро подкормленная IT-индустрией, обожает рассказывать о достижениях этой индустрии в рекламно-восхищенных тонах. Именно поэтому СМИ прожужжали вам все уши о победе машинного интеллекта в игре Го (хотя от этого нет никакой пользы в реальной жизни), но не особенно жужжали о том, что в прошлом году погибло уже как минимум два человека, которые доверили свою жизнь автопилоту автомобиля Tesla.

В этой статье я собрал некоторые наблюдения об искусственном интеллекте с эволюционной точки зрения. Это необычный подход, но как мне кажется, именно он лучше всего позволяет оценить роль AI-агентов в безопасности, а также безопасность AI в других сферах.

Среда и адаптация

Практически любая новость об искусственном интеллекте рассказывает про повышение уровня самостоятельности машин: “компьютер обыграл...”, “нейронная сеть научилась...”. Это напоминает описания лабораторных опытов с животными. Однако в изучении поведения животных учёные давно пришли к необходимости исследований в естественной среде, поскольку именно среда и адаптация к ней формируют многие свойства организмов, неочевидные и невостребованные в лабораториях.

Точно так же перспективы AI станут понятней, если вместо “идеального коня в вакууме” повнимательнее изучить среды, где AI обитает. И заметить, насколько различаются его успехи в зависимости от среды. Попытки создания машинных переводчиков длятся более полувека, на них потрачены миллиарды долларов – но всё равно для перевода с китайского вы скорее наймёте переводчика-человека, чем будете доверять программе. С другой стороны, боты для высокочастотного трейдинга, которые появились где-то в 2006 году, всего через пару лет стали играть серьёзную роль в экономических кризисах. Эти роботы просто оккупировали ту цифровую среду, в которой они чувствуют себя как рыбы в воде – то есть гораздо лучше, чем люди.

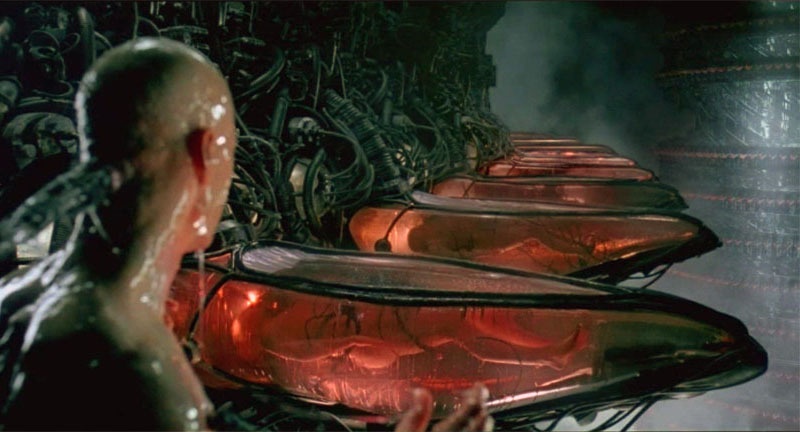

Не менее удобная цифровая среда создана для автоматизации хакерских атак: множество устройств с множеством стандартных уязвимостей внезапно объединились в общедоступный океан благодаря Интернету. Как показал опыт прошлого года, чтобы захватить миллион камер безопасности и построить из них ботнет, программе достаточно обладать минимальным интеллектом. Но только… если она одна. Следующая версия ботнета Mirai, захватившая ресурсы предыдущей, оказалась уже посложней. Так включается ещё один движок эволюции – конкуренция.

Гонка вооружений и “смешанная техника”

Удивительно, но большинство академических исследований в области AI игнорировали тот факт, что интеллект вообще – это результат жестокой битвы за выживание. Целые десятилетия теоретические “когнитивные науки” без особого успеха пытались моделировать то, что активно росло где-то рядом, в противостоянии вредоносных программ и систем безопасности.

Если вы почитаете в “Википедии” определение дисциплины Artificial Life, то не найдёте там ни слова про компьютерные вирусы – хотя они демонстрируют всё то, что эта дисциплина пытается моделировать аж с семидесятых годов. У вирусов есть адаптивное поведение (разные действия в разных условиях, умение обманывать “песочницы” и отключать антивирусы), есть самовоспроизведение с мутациями (так что сигнатуры родителей становятся бесполезны для ловли отпрысков), есть мимикрия (маскировка под легальные программы) и много ещё чего. Если уж где искать искусственную жизнь – то она именно здесь.

Помогает ли это встречному развитию интеллекта защитных систем? Конечно. Особенно если учесть, что с ними воюют не только вирусы, но и коллеги-безопасники. Например, компания Google последние два года регулярно ломает антивирусы (чужие, конечно же). Уязвимости в системах защиты находили и раньше, но благодаря Google антивирусные продукты уже начинают восприниматься как угроза. Можно предположить, что глобальный поисковик зачищает поляну, чтобы выкатить собственные продукты в области безопасности. А может уже и выкатил, но не для всех.

Здесь самое время произнести волшебные слова “машинное обучение” и “поведенческий анализ” — ведь именно такими технологиями может отличиться Google, который контролирует огромные потоки данных (индексация сайтов, почта, браузер и т.д.). Однако и эти технологии в безопасности развиваются несколько иначе, чем в академических игрушках AI.

Посмотрим для начала на когнитивные науки, которые я обвинил в тормозах. Более полувека в исследованиях поведения животных и людей шёл спор “бихевиористов” и “этологов”. Первые, преимущественно американские учёные, утверждали, что поведение – лишь набор рефлексов, реакций на окружающую среду; наиболее радикальные из них исповедовали принцип tabula rasa в отношении обучения, заявляя, что могут превратить любого новорожденного в представителя любой заданной профессии, поскольку его сознание – чистый лист, куда надо просто записать правильные инструкции. Второе направление, этология, возникло среди европейских зоологов, которые настаивали на том, что многие сложные паттерны поведения являются врожденными, и для их понимания нужно изучать устройство и эволюцию организма – то, чем вначале занималась сравнительная анатомия, а затем нейробиология и генетика.

Именно эти две группы спорящих определили академические направления развития искусственного интеллекта. Сторонники нисходящего AI пытались описать весь мир “сверху вниз”, в виде символьных правил реагирования на внешние запросы – так появились экспертные системы, диалоговые боты, поисковики. Сторонники восходящего подхода строили низкоуровневые “анатомические” модели – перцептроны, нейронные сети, клеточные автоматы. Какой подход мог победить в США в эпоху процветания бихевиоризма и идеи сознания как “чистого листа”? Конечно, нисходящий. Лишь ближе к концу XX века восходящие реабилитировались.

Однако на протяжении десятилетий в теориях AI почти не развивалась идея о том, что лучшая модель интеллекта должна быть “смешанной”, способной применять разные методы. Такие модели стали появляться только в конце XX века, причём опять-таки не самостоятельно, а вслед за достижениями естественных наук. Свёрточные нейронные сети возникли после того, как выяснилось, что клетки зрительной коры кошки обрабатывают изображения в две стадии: сначала простые клетки выявляют простые элементы образа (линии под разными углами), а затем на других клетках происходит распознавание изображения как набора из этих простых элементов. Без кошки, конечно, нельзя было догадаться.

Ещё один яркий пример – метания Марвина Мински, который в 50-е годы стал создателем теории нейронных сетей, в 70-е разочаровался в них и подался к “нисходящим”, а в 2006 году покаялся и выпустил книгу The Emotion Machine, где разругал рациональную логику. Неужели до этого люди не догадывались, что эмоции – это другой, не менее важный вид интеллекта? Конечно, догадывались. Но чтобы сделать из этого уважаемую науку, им понадобилось дождаться появления MRT-сканнеров с красивыми картинками. Без картинок в науке – никак.

А вот эволюция через гонку вооружений в дикой среде Интернета идёт значительно быстрее. Межсетевые экраны уровня приложений (WAF) появились совсем недавно: гартнеровский рейтинг Magic Quadrant для WAF выпускается только с 2014 года. Тем не менее, уже на момент этих первых сравнительных исследований оказалось, что некоторые WAF используют сразу несколько “разных интеллектов”. Это и сигнатуры атак (нисходящий символьный интеллект), и поведенческий анализ на основе машинного обучения (строится статистическая модель нормального функционирования системы, а затем выявляются аномалии), и сканнеры уязвимостей для проактивного патчинга (этот вид интеллекта у людей называется “самокопание”), и корреляция событий для выявления цепочек атак во времени (кто-нибудь в академических разработках AI строил интеллект, способный работать с концепцией времени?). Осталось добавить сверху ещё какой-нибудь “женский интеллект”, который будет сообщать об атаках приятным голосом – и вот вам вполне реалистичная модель человеческого разума, как минимум в плане разнообразия способов .

Имитация и ко-эволюция

Выше было сказано, что теоретики AI сильно зависели от веяний когнитивных наук. Ну ладно, они не интересовались компьютерными вирусами – но может быть, вместо этого они научились хорошо имитировать человека, по заветам великого Тьюринга?

Едва ли. Уже много лет различные визионеры обещают, что рекламные системы, собрав наши персональные данные, вкусы и интересы, начнут довольно точно предсказывать наше поведение – и получать всякие выгоды от такой прозорливости. Но на практике мы видим, что контекстная реклама целый месяц показывает нам вещь, которую мы уже давно купили, а Facebook скрывает письма, которые на самом деле являются важными.

Означает ли это, что человек очень сложен для имитации? Но с другой стороны, один из главных трендов года – множество серьёзных атак на основе банального фишинга. Многомиллионные потери банков, утечка переписки крупных политиков, заблокированные компьютеры метро Сан-Франциско – всё начинается с того, что один человек открывает одно электронное письмо. Там нет никакой имитации голоса или логичного диалога, никакой нейронной сети. Просто одно письмо с правильным заголовком.

Так может, для более реалистичной картины мира стоит переписать тьютинговское определение с точки зрения безопасности? — давайте считать машину “мыслящей”, если она может обокрасть человека. Да-да, это нарушает красивые философские представления об интеллекте. Зато становится понятно, что имитация человека на основе его прошлого опыта (поисковые запросы, история переписки) упускает из виду множество других вариантов. Человек может заинтересоваться вещами, которые задевают самые базовые всеобщие ценности (эротика) — или наоборот, включают любопытство в отношении редких явлений, вообще не встречавшихся в прошлом опыте этого человека (победа в лотерее).

Кстати, многие фантасты чувствовали, что из всех вариантов “игры в имитацию” наибольшего внимания стоит именно та, которая связана с безопасностью. Не так уж важно, что у Филипа Дика андроидов вычисляли по неправильной эмоциональной реакции (это можно подделать), а у Мерси Шелли – по неумению написать хайку (этого и большинство людей не умеют). Важно, что это была игра на выживание, а не просто подражание. Сравните это с расплывчатыми целями контекстной рекламы – включая такую великую цель, как “освоить заданный бюджет, но при этом дать понять, что этого мало”. И вы поймёте, почему искусственный интеллект рекламных систем не торопится развиваться, в отличие от систем безопасности.

И ещё один вывод, который можно сделать из успешности фишинговых атак — совместная эволюция машин и людей влияет на обе стороны этого симбиоза. Боты пока с трудом говорят по-человечески, зато у нас уже есть сотни тысяч людей, которые всю жизнь говорят и думают на машинных языках; раньше этих бедняг честно называли “программистами”, теперь их политкорректно маскируют под словом “разработчики”. Да и остальные миллионы граждан, подсев на машинные форматы

Более того, замена разнообразного сенсорного опыта на один шаблонный канал коммуникации (окно смартфона с френдлентой Фейсбука) ведёт к тому, что внушить человеку чужой выбор становится проще, чем вычислять его собственные вкусы. В начале прошлого века Ленину приходилось часами вживую выступать с броневика для убеждения народных масс, которые считались “неграмотными” — но сегодня такой же эффект на грамотных людей оказывают банальные спам-боты в социальных сетях. Они не только разводят граждан на миллионы долларов, но и участвуют в государственных переворотах – так что агентство стратегических исследований DARPA уже воспринимает их как оружие и проводит конкурс по борьбе с ними.

И вот что забавно: в конкурсе DARPA методы защиты предполагают гонку вооружений в той же электронной среде социальных сетей, словно такая среда является неизменной данностью. Хотя это как раз тот случай, который отличает нас от животных: люди сами создали цифровую среду, в которой даже простые боты легко дурят человека. А значит, мы можем проделать и обратный трюк в целях безопасности. Высуши болото, вымрут и малярийные комары.

Возможно, такой подход покажется кому-то архаичным – дескать, автор предлагает отказаться от прогресса. Поэтому приведу более практичный пример. В прошлом году появилось несколько исследований, авторы которых используют машинное обучение для подслушивания паролей через «сопутствующие» электронные среды – например, через флуктуации сигнала Wi-Fi при нажатии клавиш, или через включенный рядом Skype, позволяющий записать звук этих самых клавиш. Ну и что, будем изобретать в ответ новые системы зашумления эфира? Едва ли. Во многих случаях эффективнее будет вырубить лишний «эфир» на момент идентификации, да и самую идентификацию по паролю (простой машинный язык!) заменить на нечто менее примитивное.

Паразиты сложности и AI-психиатры

Поскольку в предыдущих строках я принизил AI до простых социоботов, теперь поговорим об обратной проблеме — о сложности. Любую новость об умных нейронных сетях можно продолжить шуткой о том, что их достижения никак не относятся к людям. Например, читаем заголовок “Нейронная сеть научилась отличать преступников” — и продолжаем “… а её создатели не научились”. Ну в самом деле, как вы можете интерпретировать или перенести куда-то знания, которые представляют собой абстрактные весовые коэффициенты, размазанные по тысячам узлов и связей нейросети? Любая система на основе такого машинного обучения – это “чёрный ящик”.

Другой парадокс сложных систем состоит в том, что они ломаются простыми способами. В природе это с успехом демонстрируют различные паразиты: даже одноклеточное существо вроде токсоплазмы умудряется управлять сложнейшими организмами млекопитающих.

Вместе эти два свойства интеллектуальных систем дают отличную цель для хакеров: взломать — легко, зато отличить взломанную систему от нормальной – тяжело.

Первыми с этим столкнулись поисковики: на них пышным цветом расцвёл паразитный бизнес поисковой оптимизации (SEO). Достаточно было скормить поисковику определённую “наживку”, и заданный сайт попадал в первые строки выдачи по заданным запросам. А поскольку алгоритмы поисковика для обычного пользователя непонятны, то он зачастую и не подозревает о такой манипуляции.

Конечно, можно выявлять косяки “чёрного ящика” с помощью внешней оценки экспертами-людьми. Сервис Google Flu Trends вообще перестал публиковать свои предсказания после публикации исследования, которое выявило, что этот сервис сильно преувеличивал все эпидемии гриппа с 2011 по 2014-й, что могло быть связано с банальной накруткой поисковых запросов. Но это тихое закрытие – скорее исключение: обычно сервисы с подобными косяками продолжают жить, не зря же на них деньги тратили! Сейчас, когда я пишу эти строки, Яндекс.Переводчик говорит мне, что “bulk” переводится как “Навальный”. Но у этого глючного интеллекта есть трогательная кнопка “Сообщить об ошибке” — и возможно, если ею воспользуются ещё пятьсот вменяемых людей, накрученный Навальный тоже сгинет.

Постоянными человеческими поправками кормятся теперь и сами поисковики, хотя они не любят это признавать, и даже название для этой профессии придумали максимально загадочное (“асессор”). Но по факту – на галерах машинного обучения Гугла и Яндекса вкалывают тысячи людей-тестировщиков, которые целыми днями занимаются унылой работой по оценке результатов работы поисковиков, для последующей корректировки алгоритмов. О тяжкой доле этих бурлаков не знал президент Обама, когда в своей прощальной речи обещал, что искусственный интеллект освободит людей от низкоквалифицированной работы.

Но поможет ли такой саппорт, когда уровень сложности повысится до персонального искусственного интеллекта, с которым все несчастные будут несчастливы по-своему? Скажем, ваша персональная Siri или Alexa выдала вам странный ответ. Что это, недостатки стороннего поисковика? Или косяк самообучения по вашей прошлой истории покупок? Или разработчики просто добавили боту немного спонтанности и юмора в синтезатор речи, чтобы он звучал более естественно? Или ваш AI-агент взломан хакерами? Очень непросто будет выяснить.

Добавим сюда, что влияние интеллектуальных агентов уже не ограничивается “ответами на вопросы”. Взломанный бот из игры дополненной реальности, типа Pokemon Go, может подвергнуть опасности целую толпу людей, заводя их в места, более удобные для грабежа. А если уже упомянутая “Тесла” на автопилоте врезается в мирно стоящий грузовик, как это случалось не раз в прошлом году – у вас просто нет времени позвонить в саппорт.

Может, нас спасут более умные системы безопасности? Но вот беда: становясь более сложными и вооружаясь машинным обучением, они тоже превращаются в “чёрные ящики”. Уже сейчас системы мониторинга событий безопасности (SIEM) собирают столько данных, что их анализ напоминает то ли гадание шамана на внутренностях животных, то ли общение дрессировщика со львом. По сути, это новый рынок профессий будущего, среди которых AI-психиатр – даже не самая шизовая.

Моральный Бендер

Вы наверняка заметили, что описанные в этой статье отношения людей и машин – конкуренция, симбиоз, паразитизм – не включают более привычную картинку, где умные машины являются послушными слугами людей и заботятся только о человеческом благе. Да-да, все мы читали Азимова с его принципами робототехники. Но в реальности ничего подобного в системах искусственного интеллекта до сих пор нет. И неудивительно: люди сами пока не понимают, как можно жить, не причиняя вреда никакому другому человеку. Более популярная мораль состоит в том, чтобы заботится о благе для определенной группы людей – но другим группам при этом можно и навредить. Все равны, но некоторые равнее.

В сентябре 2016-го британский Институт стандартов выпустил “Руководство по этическому дизайну роботов”. А в октябре исследователи из Google представили свой “тест на дискриминацию” для AI-алгоритмов. Примеры в этих документах очень схожи. Британцы переживают, что полицию захватят роботы-сексисты: на основе данных о более частых преступлениях среди чернокожих система начинает считать более подозрительными именно чернокожих. А американцы жалуются на слишком разборчивый банковский AI: если мужчины вдвое чаще оказываются неспособны выплатить кредит, чем женщины, машинный алгоритм на основе таких данных может предложить банку выигрышную стратегию, которая заключается в выдаче кредитов преимущественно женщинам. Это будет “недопустимая дискриминация”.

Вроде всё логично – но ведь устраивая равноправие в этих случаях, можно запросто увеличить риски для других людей. Да и как вообще машина будет применять абстрактную этику вместо голой статистики?

Вероятно, это и есть главный нынешний тренд в теме “безопасность AI” — попытки ограничить искусственный интеллект с помощью принципов, которые сами по себе сомнительны. В октябре прошлого года администрация президента США выпустила документ под названием "Подготовка к будущему искусственного интеллекта”. В документе упомянуты многие из тех рисков, которые я описал выше. Однако ответом на все проблемы являются размытые рекомендации о том, что “надо тестировать, надо убеждаться в безопасности”. Из содержательных законов, касающихся AI, названы только новые правила министерства транспорта США по поводу коммерческого использования беспилотников – им, например, запрещено летать над людьми. С другой стороны, главка про летальное автономное оружие (LAWS) скромно сообщает, что “будущее LAWS сложно предсказать”, хотя оно уже давно используется.

Ту же тему развил Европарламент, который в начале 2017 года опубликовал свой набор расплывчатых рекомендаций о том, как внедрять этику в роботов. Здесь даже сделана попытка определить их юридический статус, не такой уж далёкий от человеческого — “электронная личность со специальными правами и обязанностями”. Ещё немного, и нам запретят стирать глючные программы, чтобы не нарушить их права. Впрочем, у российских собственная гордость: представители Госдумы РФ сравнивают искусственный интеллект с собакой, на которую нужно надеть намордник. На этом месте появляется прекрасная тема для протестных выступлений – за свободу роботов в отдельнно взятой стране.

Шутки шутками, но не исключено, что именно в этих туманных принципах кроется лучшее решение проблемы безопасности AI. Нам-то кажется, что эволюционная гонка вооружений может развить искусственные интеллекты до опасного превосходства над Homo sapiens. Но когда умным машинам придётся столкнуться с человеческой бюрократией, этикой и политкорректностью, это может значительно притупить весь их интеллект.

===============================

Автор: Алексей Андреев, Positive Technologies

Автор: Positive Technologies